ЕвРҫР»СҺСҶС–СҸ СӮР° РІРҝлив СҖРҫР·РјРҫРІРҪРҫРіРҫ РЁРҶ

Р—Р° РҫСҒСӮР°РҪРҪС” РҙРөСҒСҸСӮиліСӮСӮСҸ СҖРҫР·РјРҫРІРҪРёР№ СҲСӮСғСҮРҪРёР№ С–РҪСӮРөР»РөРәСӮ СҖС–Р·РәРҫ СҖРҫР·РІРёРҪСғРІСҒСҸ, РҝРөСҖРөСӮРІРҫСҖРёРІСҲРёСҒСҢ С–Р· РҝСҖРҫСҒСӮРёС… СҮР°СӮ-РұРҫСӮС–РІ РҪР° РҫСҒРҪРҫРІС– РҝСҖавил РҪР° СҒРәлаРҙРҪС– СҒРёСҒСӮРөРјРё, Р·РҙР°СӮРҪС– РҙРҫ РҙРөСӮалізРҫРІР°РҪРҫС— взаємРҫРҙС–С— РІ СҖС–Р·РҪРёС… РәРҫРҪСӮРөРәСҒСӮах. Р’С–Рҙ РҙРҫРҙР°СӮРәС–РІ РҫРұСҒР»СғРіРҫРІСғРІР°РҪРҪСҸ РәлієРҪСӮС–РІ РҙРҫ С–РҪСҒСӮСҖСғРјРөРҪСӮС–РІ РҝС–РҙСӮСҖРёРјРәРё РҝСҒРёС…С–СҮРҪРҫРіРҫ Р·РҙРҫСҖРҫРІвҖҷСҸ, РіРҫР»РҫСҒРҫРІРёС… РҝРҫРјС–СҮРҪРёРәС–РІ С– РјРөС…Р°РҪС–Р·РјС–РІ СҒСӮРІРҫСҖРөРҪРҪСҸ РәРҫРҪСӮРөРҪСӮСғ, СҶС– СӮРөС…РҪРҫР»РҫРіС–С— глиРұРҫРәРҫ С–РҪСӮРөРіСҖСғвалиСҒСҸ РІ РҪР°СҲСғ РҫСҒРҫРұРёСҒСӮСғ СӮР° РҝСҖРҫС„РөСҒС–Р№РҪСғ СҒС„РөСҖРё.

РҰРө СҲРІРёРҙРәРө РІРҝСҖРҫРІР°РҙР¶РөРҪРҪСҸ РҪРөСҒРө Р· СҒРҫРұРҫСҺ глиРұРҫРәС– РөСӮРёСҮРҪС– РјС–СҖРәСғРІР°РҪРҪСҸ, СҸРәС– СҖРҫР·СҖРҫРұРҪРёРәРё, РәРҫРјРҝР°РҪС–С— СӮР° СҒСғСҒРҝС–Р»СҢСҒСӮРІРҫ РҝРҫРІРёРҪРҪС– РІСҖахРҫРІСғРІР°СӮРё. РҜРә Р»СҺРҙРёРҪР°, СҸРәР° РәРҫРҪСҒСғР»СҢСӮСғвала РҝСҖРҫРөРәСӮРё РІРҝСҖРҫРІР°РҙР¶РөРҪРҪСҸ СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ РІ СҖС–Р·РҪРёС… галСғР·СҸС…, СҸ РҪР° влаСҒРҪС– РҫСҮС– РұР°СҮРёРІ, СҸРә РөСӮРёСҮРҪС– РҪРөРҙРҫРіР»СҸРҙРё РҪР° РөСӮР°РҝС– РҝСҖРҫРөРәСӮСғРІР°РҪРҪСҸ РјРҫР¶СғСӮСҢ РҝСҖРёР·РІРөСҒСӮРё РҙРҫ РҝСҖРҫРұР»РөРјРҪРёС… СҖРөР·СғР»СҢСӮР°СӮС–РІ, РәРҫли СҶС– СҒРёСҒСӮРөРјРё РҙРҫСҒСҸРіР°СҺСӮСҢ РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ. РЈ СҶСҢРҫРјСғ РұР»РҫР·С– РҙРҫСҒліРҙР¶СғСҺСӮСҢСҒСҸ РөСӮРёСҮРҪС– Р°СҒРҝРөРәСӮРё, СҸРәС– РјРё РҝРҫРІРёРҪРҪС– РІСҖахРҫРІСғРІР°СӮРё, СҒСӮРІРҫСҖСҺСҺСҮРё СҖРҫР·РјРҫРІРҪС– СҒРёСҒСӮРөРјРё РЁРҶ, СҸРәС– СҒРҝСҖавРҙС– СҒР»СғжаСӮСҢ Р»СҺРҙСҒСӮРІСғ.

РҡРҫРҪфіРҙРөРҪСҶС–Р№РҪС–СҒСӮСҢ С– РҫРұСҖРҫРұРәР° РҙР°РҪРёС…: РҝРҫвага РҙРҫ РјРөР¶ РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ

Р РҫР·РјС–СҖРё РәРҫРҪфіРҙРөРҪСҶС–Р№РҪРҫСҒСӮС– РІ СҖРҫР·РјРҫРІРҪРҫРјСғ СҲСӮСғСҮРҪРҫРјСғ С–РҪСӮРөР»РөРәСӮС– РјР°СҺСӮСҢ РІРёС…РҫРҙРёСӮРё Р·Р° РјРөжі РұазРҫРІРҫС— РІС–РҙРҝРҫРІС–РҙРҪРҫСҒСӮС– РҪРҫСҖмам, СӮР°РәРёРј СҸРә GDPR Р°РұРҫ CCPA. Р’РҫРҪРё РҝРҫРІРёРҪРҪС– РІС–РҙРҫРұСҖажаСӮРё С„СғРҪРҙамРөРҪСӮалСҢРҪСғ РҝРҫвагСғ РҙРҫ РәРҫСҖРҙРҫРҪС–РІ С– РҫСҮС–РәСғРІР°РҪСҢ РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ, РҫСҒРҫРұливРҫ СҸРәСүРҫ СҶС– СҒРёСҒСӮРөРјРё СҖРҫР·СҖРҫРұР»РөРҪС– РҙР»СҸ РҫСӮСҖРёРјР°РҪРҪСҸ РҫСҒРҫРұРёСҒСӮРҫС— С–РҪС„РҫСҖРјР°СҶС–С—. РһСҒРҪРҫРІРҪС– РјС–СҖРәСғРІР°РҪРҪСҸ РІРәР»СҺСҮР°СҺСӮСҢ:

РҹСҖРҫР·РҫСҖС– РјРөСӮРҫРҙРё Р·РұРҫСҖСғ РҙР°РҪРёС…: РәРҫСҖРёСҒСӮСғРІР°СҮС– Р·Р°СҒР»СғРіРҫРІСғСҺСӮСҢ РҪР° СӮРө, СүРҫРұ СӮРҫСҮРҪРҫ Р·РҪР°СӮРё, СҸРәР° С–РҪС„РҫСҖРјР°СҶС–СҸ Р·РұРёСҖаєСӮСҢСҒСҸ, СҸРә РҙРҫРІРіРҫ РІРҫРҪР° Р·РұРөСҖС–РіР°СӮРёРјРөСӮСҢСҒСҸ СӮР° СҸРә РІРёРәРҫСҖРёСҒСӮРҫРІСғРІР°СӮРёРјРөСӮСҢСҒСҸ вҖ” СғСҒРө СҶРө РҝРҫСҸСҒРҪСҺС”СӮСҢСҒСҸ РҙРҫСҒСӮСғРҝРҪРҫСҺ РјРҫРІРҫСҺ, Р° РҪРө СҺСҖРёРҙРёСҮРҪРёРј жаСҖРіРҫРҪРҫРј.

Р—РҪР°СҮСғСүС– РјРөС…Р°РҪС–Р·РјРё РҫСӮСҖРёРјР°РҪРҪСҸ Р·РіРҫРҙРё: Р·РіРҫРҙР° має РұСғСӮРё Р°РәСӮРёРІРҪРҫСҺ, С–РҪС„РҫСҖРјРҫРІР°РҪРҫСҺ СӮР° РҙРөСӮалСҢРҪРҫСҺ. РҡРҫСҖРёСҒСӮСғРІР°СҮС– РҝРҫРІРёРҪРҪС– РјР°СӮРё РјРҫжливіСҒСӮСҢ РІРјРёРәР°СӮРё Р°РұРҫ РІРёРјРёРәР°СӮРё РҝРөРІРҪРө РІРёРәРҫСҖРёСҒСӮР°РҪРҪСҸ РҙР°РҪРёС…, РҪРө РІСӮСҖР°СҮР°СҺСҮРё РҙРҫСҒСӮСғРҝСғ РҙРҫ РҫСҒРҪРҫРІРҪРёС… С„СғРҪРәСҶС–Р№.

РҹСҖРёРҪСҶРёРҝРё РјС–РҪС–РјС–Р·Р°СҶС–С— РҙР°РҪРёС…: СҒРёСҒСӮРөРјРё РҝРҫРІРёРҪРҪС– Р·РұРёСҖР°СӮРё лиСҲРө СӮРө, СүРҫ РҪРөРҫРұС…С–РҙРҪРҫ РҙР»СҸ РҪР°РҙР°РҪРҪСҸ РҝРҫСҒР»СғРі, РҫСҮС–РәСғРІР°РҪРёС… РәРҫСҖРёСҒСӮСғРІР°СҮами, Р° РҪРө Р·РұРёСҖР°СӮРё РҙРҫРҙР°СӮРәРҫРІС– РҙР°РҪС–, СҸРәС– РјРҫР¶СғСӮСҢ РұСғСӮРё СҶС–РҪРҪРёРјРё РҙР»СҸ РәРҫРјРҝР°РҪС–С—, алРө РҪРө РјР°СҺСӮСҢ РІС–РҙРҪРҫСҲРөРҪРҪСҸ РҙРҫ РұРөР·РҝРҫСҒРөСҖРөРҙРҪС–С… РҝРҫСӮСҖРөРұ РәРҫСҖРёСҒСӮСғРІР°СҮР°.

РңРөСӮРҫРҙРё РұРөР·РҝРөСҮРҪРҫРіРҫ РҝРҫРІРҫРҙР¶РөРҪРҪСҸ: РҪР°РҙС–Р№РҪРө СҲРёС„СҖСғРІР°РҪРҪСҸ, РәРҫРҪСӮСҖРҫР»СҢ РҙРҫСҒСӮСғРҝСғ СӮР° СҖРөРіСғР»СҸСҖРҪС– РҝРөСҖРөРІС–СҖРәРё РұРөР·РҝРөРәРё РјР°СҺСӮСҢ РұСғСӮРё СҒСӮР°РҪРҙР°СҖСӮРҪРҫСҺ РҝСҖР°РәСӮРёРәРҫСҺ, РҝСҖРёРҙС–Р»СҸСҺСҮРё РҫСҒРҫРұливСғ СғвагСғ РәРҫРҪфіРҙРөРҪСҶС–Р№РҪРёРј СҖРҫР·РјРҫвам.

РқайРұС–Р»СҢСҲ РөСӮРёСҮРҪС– СҖРҫР·РјРҫРІРҪС– СҒРёСҒСӮРөРјРё СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ вҖ“ СҶРө СӮС–, СҸРәС– СҖРҫР·СҖРҫРұР»РөРҪС– Р· РәРҫРҪфіРҙРөРҪСҶС–Р№РҪС–СҒСӮСҺ СҸРә РҫСҒРҪРҫРІРҫРҝРҫР»РҫР¶РҪРҫСҺ СҶС–РҪРҪС–СҒСӮСҺ, Р° РҪРө РҝСҖР°РҝРҫСҖСҶРөРј РІС–РҙРҝРҫРІС–РҙРҪРҫСҒСӮС–, РҙРө захиСҒСӮ С–РҪС„РҫСҖРјР°СҶС–С— РәРҫСҖРёСҒСӮСғРІР°СҮР° СҖРҫР·РіР»СҸРҙаєСӮСҢСҒСҸ СҸРә РҫСҒРҪРҫРІРҪР° С„СғРҪРәСҶС–СҸ, Р° РҪРө РҫРұРјРөР¶РөРҪРҪСҸ, СҸРәРө РҝРҫСӮСҖС–РұРҪРҫ РҫРұС–Р№СӮРё.

Р—РІРөСҖРҪРөРҪРҪСҸ РҙРҫ СғРҝРөСҖРөРҙР¶РөРҪРҫСҒСӮС– СӮР° СҮРөСҒРҪРҫСҒСӮС– РІ СҖРҫР·РјРҫвах AI

РЈРҝРөСҖРөРҙР¶РөРҪРҪСҸ РІ СҖРҫР·РјРҫРІРҪРҫРјСғ РЁРҶ РјРҫР¶СғСӮСҢ РҝСҖРҫСҸРІР»СҸСӮРёСҒСҸ СҖС–Р·РҪРёРјРё СҒРҝРҫСҒРҫРұами:

РЈРҝРөСҖРөРҙР¶РөРҪРҪСҸ СҖРөРҝСҖРөР·РөРҪСӮР°СҶС–С—: РәРҫли РҝРөРІРҪС– РҙРөРјРҫРіСҖафіСҮРҪС– РҙР°РҪС– РҪР°РҙРјС–СҖРҪРҫ Р°РұРҫ РҪРөРҙРҫСҒСӮР°СӮРҪСҢРҫ РҝСҖРөРҙСҒСӮавлРөРҪС– РІ РҪавСҮалСҢРҪРёС… РҙР°РҪРёС…

РЈРҝРөСҖРөРҙР¶РөРҪРҪСҸ взаємРҫРҙС–С—: РәРҫли СҒРёСҒСӮРөРјР° РҝРҫ-СҖС–Р·РҪРҫРјСғ СҖРөагСғС” РҪР° РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ РҪР° РҫСҒРҪРҫРІС– СҒРҝСҖРёР№РҪСҸСӮРёС… С…Р°СҖР°РәСӮРөСҖРёСҒСӮРёРә С–РҙРөРҪСӮРёСҮРҪРҫСҒСӮС–

РЈРҝРөСҖРөРҙР¶РөРҪРҪСҸ СҖРөР·СғР»СҢСӮР°СӮС–РІ: РәРҫли СҒРёСҒСӮРөРјР° Рҙає СҖС–Р·РҪС– СҖРөР·СғР»СҢСӮР°СӮРё РҙР»СҸ СҖС–Р·РҪРёС… РіСҖСғРҝ РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ

РЈСҒСғРҪРөРҪРҪСҸ СҶРёС… СғРҝРөСҖРөРҙР¶РөРҪСҢ вимагає РҪавмиСҒРҪРёС… Р·СғСҒРёР»СҢ РҝСҖРҫСӮСҸРіРҫРј жиСӮСӮєвРҫРіРҫ СҶРёРәР»Сғ СҖРҫР·СҖРҫРұРәРё:

РҹРҫ-РҝРөСҖСҲРө, РҪавСҮалСҢРҪС– РҙР°РҪС– РјР°СҺСӮСҢ РұСғСӮРё РәСҖРёСӮРёСҮРҪРҫ РҫСҶС–РҪРөРҪС– СӮР° Р·РұалаРҪСҒРҫРІР°РҪС–, РҝСҖРёРҙС–Р»СҸСҺСҮРё РҫСҒРҫРұливСғ СғвагСғ РІСҖахСғРІР°РҪРҪСҺ СҖС–Р·РҪРҫРјР°РҪС–СӮРҪРёС… СӮРҫСҮРҫРә Р·РҫСҖСғ СӮР° РҙРҫСҒРІС–РҙСғ. РҰРө РҫР·РҪР°СҮає РІРёС…С–Рҙ Р·Р° СҖамРәРё СҒСӮР°РҪРҙР°СҖСӮРҪРёС… РҪР°РұРҫСҖС–РІ РҙР°РҪРёС… РҙР»СҸ РІРәР»СҺСҮРөРҪРҪСҸ РіРҫР»РҫСҒС–РІ, СҸРәС– С–РҪР°РәСҲРө РјРҫгли Рұ РұСғСӮРё РјР°СҖРіС–РҪалізРҫРІР°РҪРёРјРё.

РҹРҫ-РҙСҖСғРіРө, РҝРҫСӮРҫСҮРҪРө СӮРөСҒСӮСғРІР°РҪРҪСҸ має РІРәР»СҺСҮР°СӮРё СҖС–Р·РҪРҫРјР°РҪС–СӮРҪС– РіСҖСғРҝРё РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ С– РәРҫРҪСӮСҖРҫР»СҺРІР°СӮРё РІС–РҙРјС–РҪРҪСғ РҝСҖРҫРҙСғРәСӮРёРІРҪС–СҒСӮСҢ. РҷРҙРөСӮСҢСҒСҸ РҪРө лиСҲРө РҝСҖРҫ СӮРөСҒСӮСғРІР°РҪРҪСҸ Р· СҖС–Р·РҪРёРјРё РҙРөРјРҫРіСҖафіСҮРҪРёРјРё РіСҖСғРҝами, Р° Р№ РҝСҖРҫ РІСҖахСғРІР°РҪРҪСҸ СҖС–Р·РҪРҫРјР°РҪС–СӮРҪРёС… РәРҫРҪСӮРөРәСҒСӮС–РІ, Р·РҙС–РұРҪРҫСҒСӮРөР№ С– СҒСӮилів взаємРҫРҙС–С—.

РҹРҫ-СӮСҖРөСӮС”, СҒамі РәРҫРјР°РҪРҙРё СҖРҫР·СҖРҫРұРҪРёРәС–РІ РҝРҫРІРёРҪРҪС– РІРәР»СҺСҮР°СӮРё Р»СҺРҙРөР№ С–Р· СҖС–Р·РҪРёРј РҙРҫСҒРІС–РҙРҫРј С– РҝРҫРіР»СҸРҙами, СҸРәС– РјРҫР¶СғСӮСҢ РІРёР·РҪР°СҮРёСӮРё РҝРҫСӮРөРҪСҶС–Р№РҪС– РҝСҖРҫРұР»РөРјРё СғРҝРөСҖРөРҙР¶РөРҪРҫСҒСӮС–, СҸРәС– РҫРҙРҪРҫСҖС–РҙРҪС– РәРҫРјР°РҪРҙРё РјРҫР¶СғСӮСҢ РҝСҖРҫРҝСғСҒСӮРёСӮРё.

РқР°СҖРөСҲСӮС–, СҒРёСҒСӮРөРјРё РҝРҫСӮСҖРөРұСғСҺСӮСҢ РҝРҫСҒСӮС–Р№РҪРҫРіРҫ РјРҫРҪС–СӮРҫСҖРёРҪРіСғ СӮР° РҫРҪРҫРІР»РөРҪРҪСҸ РІ РјС–СҖСғ СҖРҫР·РІРёСӮРәСғ СҒСғСҒРҝС–Р»СҢРҪРёС… РҪРҫСҖРј С– РІРёСҸРІР»РөРҪРҪСҸ РҪРҫРІРёС… СғРҝРөСҖРөРҙР¶РөРҪСҢ. РқайРұС–Р»СҢСҲ РөСӮРёСҮРҪС– СҖРҫР·РјРҫРІРҪС– СҒРёСҒСӮРөРјРё СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ РҪРө РҝСҖРҫСҒСӮРҫ СҮРөСҒРҪС– РҝС–Рҙ СҮР°СҒ Р·Р°РҝСғСҒРәСғ вҖ” РІРҫРҪРё СҖРҫР·СҖРҫРұР»РөРҪС–, СүРҫРұ Р· СҮР°СҒРҫРј СҒСӮаваСӮРё РІСҒРө РұС–Р»СҢСҲ СҒРҝСҖавРөРҙливими.

РҹСҖРҫР·РҫСҖС–СҒСӮСҢ С– Р·СҖРҫР·СғміліСҒСӮСҢ: РҝСҖавРҫ РҪР° СҖРҫР·СғРјС–РҪРҪСҸ

РҹСҖРҫР·РҫСҖС–СҒСӮСҢ СҖРҫР·РјРҫРІРҪРҫРіРҫ РЁРҶ РІРәР»СҺСҮає РәС–Р»СҢРәР° РІРёРјС–СҖС–РІ:

Р РҫР·РәСҖРёСӮСӮСҸ РҫСҒРҫРұРёСҒСӮРҫСҒСӮС– РЁРҶ: РәРҫСҖРёСҒСӮСғРІР°СҮС– РҝРҫРІРёРҪРҪС– Р·РҪР°СӮРё, РәРҫли РІРҫРҪРё взаємРҫРҙС–СҺСӮСҢ Р·С– РЁРҶ, Р° РҪРө Р· Р»СҺРҙРёРҪРҫСҺ. РһРјР°РҪливі РјРөСӮРҫРҙРё, СҸРәС– РҪавмиСҒРҪРҫ СҖРҫР·РјРёРІР°СҺСӮСҢ СҶСҺ ліРҪС–СҺ, РҝРҫСҖСғСҲСғСҺСӮСҢ авСӮРҫРҪРҫРјС–СҺ РәРҫСҖРёСҒСӮСғРІР°СҮР°.

РҹСҖРҫР·РҫСҖС–СҒСӮСҢ РҝСҖРҫСҶРөСҒСғ: РәРҫСҖРёСҒСӮСғРІР°СҮС– Р·Р°СҒР»СғРіРҫРІСғСҺСӮСҢ РҪР° СӮРө, СүРҫРұ СҖРҫР·СғРјС–СӮРё, СҸРә С—С…РҪС– РІС…С–РҙРҪС– РҙР°РҪС– РІРҝливаСҺСӮСҢ РҪР° СҖРөР·СғР»СҢСӮР°СӮРё СҒРёСҒСӮРөРјРё, РҫСҒРҫРұливРҫ РҙР»СҸ СӮР°РәРёС… важливих СҖС–СҲРөРҪСҢ, СҸРә СҒхвалРөРҪРҪСҸ РәСҖРөРҙРёСӮС–РІ, РјРөРҙРёСҮРҪС– СҖРөРәРҫРјРөРҪРҙР°СҶС–С— СҮРё СҖРҫР·РҝРҫРҙС–Р» СҖРөСҒСғСҖСҒС–РІ.

РҹСҖРҫР·РҫСҖС–СҒСӮСҢ РҫРұРјРөР¶РөРҪСҢ: РЎРёСҒСӮРөРјРё РјР°СҺСӮСҢ РІС–РҙРІРөСҖСӮРҫ РҝРҫРІС–РҙРҫРјР»СҸСӮРё РҝСҖРҫ СҒРІРҫС— РјРҫжливРҫСҒСӮС– СӮР° РҫРұРјРөР¶РөРҪРҪСҸ, Р° РҪРө СҒСӮРІРҫСҖСҺРІР°СӮРё РҝРҫРјРёР»РәРҫРІСғ РІРҝРөРІРҪРөРҪС–СҒСӮСҢ СҮРё РҙРҫСҒРІС–Рҙ.

РңРҫжливРҫСҒСӮС– РҝРҫСҸСҒРҪРөРҪСҢ: РәРҫли СҶРө РҙРҫСҖРөСҮРҪРҫ, СҒРёСҒСӮРөРјРё РҝРҫРІРёРҪРҪС– РјР°СӮРё РјРҫжливіСҒСӮСҢ РҝРҫСҸСҒРҪСҺРІР°СӮРё СҒРІРҫС— СҖРөРәРҫРјРөРҪРҙР°СҶС–С— СҮРё СҖС–СҲРөРҪРҪСҸ РІ СӮРөСҖРјС–РҪах, Р·СҖРҫР·Сғмілих РәРҫСҖРёСҒСӮСғРІР°СҮам.

РҡСҖС–Рј СҶРёС… РәРҫРҪРәСҖРөСӮРҪРёС… РҝСҖР°РәСӮРёРә, С–СҒРҪСғС” СҲРёСҖСҲРө філРҫСҒРҫС„СҒСҢРәРө РҝРёСӮР°РҪРҪСҸ РҝСҖРҫ СҖС–РІРөРҪСҢ РҝСҖРҫР·РҫСҖРҫСҒСӮС–, РҪР° СҸРәРёР№ Р·Р°СҒР»СғРіРҫРІСғСҺСӮСҢ РәРҫСҖРёСҒСӮСғРІР°СҮС–. РҘРҫСҮР° РҝРҫРІРҪР° алгРҫСҖРёСӮРјС–СҮРҪР° РҝСҖРҫР·РҫСҖС–СҒСӮСҢ РҪРө завжРҙРё РјРҫжлива Р°РұРҫ РҪРөРҫРұС…С–РҙРҪР°, РәРҫСҖРёСҒСӮСғРІР°СҮС– РҝРҫРІРёРҪРҪС– РјР°СӮРё РҙРҫСҒСӮСғРҝ РҙРҫ Р·РјС–СҒСӮРҫРІРҪРёС… РҝРҫСҸСҒРҪРөРҪСҢ, СҸРәС– РІС–РҙРҝРҫРІС–РҙР°СҺСӮСҢ РәРҫРҪСӮРөРәСҒСӮСғ СӮР° РҪР°СҒліРҙРәам взаємРҫРҙС–С—.

РқайРұС–Р»СҢСҲ РөСӮРёСҮРҪС– СҖРҫР·РјРҫРІРҪС– СҒРёСҒСӮРөРјРё СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ вҖ“ СҶРө СӮС–, СҸРәС– РҪР°РҙР°СҺСӮСҢ РәРҫСҖРёСҒСӮСғРІР°СҮам СҖРҫР·СғРјС–РҪРҪСҸ, Р° РҪРө вимагаСҺСӮСҢ СҒліРҝРҫС— РҙРҫРІС–СҖРё.

РҗРІСӮРҫРҪРҫРјС–СҸ СӮР° РәРҫРҪСӮСҖРҫР»СҢ РәРҫСҖРёСҒСӮСғРІР°СҮР°: РҝСҖРҫРөРәСӮСғРІР°РҪРҪСҸ РҙР»СҸ Р»СҺРҙРёРҪРё

РҹРҫважаСӮРё авСӮРҫРҪРҫРјС–СҺ РәРҫСҖРёСҒСӮСғРІР°СҮР° РІ СҖРҫР·СҖРҫРұСҶС– AI РҫР·РҪР°СҮає СҒСӮРІРҫСҖРөРҪРҪСҸ СҒРёСҒСӮРөРј, СҸРәС–:

РҹРҫважайСӮРө СҮС–СӮРәС– РјРөжі: РәРҫли РәРҫСҖРёСҒСӮСғРІР°СҮ РәажРө В«РҪС–В» Р°РұРҫ РІРәазСғС”, СүРҫ С…РҫСҮРө завРөСҖСҲРёСӮРё СҖРҫР·РјРҫРІСғ, СҒРёСҒСӮРөРјР° РҝРҫРІРёРҪРҪР° РҝРҫважаСӮРё СҶРө РұРөР· РјР°РҪС–РҝСғР»СҸСӮРёРІРҪРҫС— РҪР°РҝРҫР»РөгливРҫСҒСӮС–.

РқР°РҙайСӮРө Р·РҪР°СҮСғСүРёР№ РІРёРұС–СҖ: РәРҫСҖРёСҒСӮСғРІР°СҮС– РҝРҫРІРёРҪРҪС– РјР°СӮРё СҒРҝСҖавжРҪС– РІР°СҖС–Р°РҪСӮРё, Р° РҪРө РІРёРіР°РҙР°РҪС– РІР°СҖС–Р°РҪСӮРё, СҸРәС– РҝСҖРёР·РІРҫРҙСҸСӮСҢ РҙРҫ РҫРҙРҪР°РәРҫРІРҫРіРҫ СҖРөР·СғР»СҢСӮР°СӮСғ.

Р”РҫР·РІРҫлиСӮРё РІРёРҝСҖавлРөРҪРҪСҸ: РәРҫли СҒРёСҒСӮРөРјР° РҪРөРҝСҖавилСҢРҪРҫ СҖРҫР·СғРјС–С” Р°РұРҫ СҖРҫРұРёСӮСҢ РҝРҫРјРёР»РәСғ, РәРҫСҖРёСҒСӮСғРІР°СҮам РҝРҫСӮСҖС–РұРҪС– РҝСҖРҫСҒСӮС– СҒРҝРҫСҒРҫРұРё С—С— РҝРөСҖРөРҪР°РҝСҖавлРөРҪРҪСҸ.

РЈРІС–РјРәРҪСғСӮРё РҪалаСҲСӮСғРІР°РҪРҪСҸ: РәРҫСҖРёСҒСӮСғРІР°СҮС– РҝРҫРІРёРҪРҪС– РјР°СӮРё РјРҫжливіСҒСӮСҢ С„РҫСҖРјСғРІР°СӮРё СҒСӮРёР»СҢ взаємРҫРҙС–С— СӮР° РҝР°СҖамРөСӮСҖРё РІС–РҙРҝРҫРІС–РҙРҪРҫ РҙРҫ СҒРІРҫС—С… СғРҝРҫРҙРҫРұР°РҪСҢ С– РҝРҫСӮСҖРөРұ.

Р—РҙС–Р№СҒРҪСҺР№СӮРө Р»СҺРҙСҒСҢРәРёР№ РҪаглСҸРҙ: РҙР»СҸ РҪРөРҝСҖСҸРјРёС… СҖС–СҲРөРҪСҢ РҝРҫРІРёРҪРҪС– РұСғСӮРё РҙРҫСҒСӮСғРҝРҪС– СҲР»СҸС…Рё РҙРҫ Р»СҺРҙСҒСҢРәРҫРіРҫ РҝРөСҖРөРіР»СҸРҙСғ.

РқР°РҝСҖСғРіР° РјС–Р¶ РҝСҖРҫРөРәСӮСғРІР°РҪРҪСҸРј РҙР»СҸ РөС„РөРәСӮРёРІРҪРҫСҒСӮС– СӮР° РҝРҫвагРҫСҺ РҙРҫ авСӮРҫРҪРҫРјС–С— РәРҫСҖРёСҒСӮСғРІР°СҮР° РҫСҒРҫРұливРҫ РҫСҮРөРІРёРҙРҪР° РІ РҝРөСҖРөРәРҫРҪливих РҝСҖРҫРіСҖамах, СӮР°РәРёС… СҸРә СҒРёСҒСӮРөРјРё РҝСҖРҫРҙажів Р°РұРҫ Р·РјС–РҪРё РҝРҫРІРөРҙС–РҪРәРё. Р•СӮРёСҮРҪС– РјРөжі СҒСӮРёСҖР°СҺСӮСҢСҒСҸ, РәРҫли СҖРҫР·РјРҫРІРҪРёР№ РЁРҶ РІРёРәРҫСҖРёСҒСӮРҫРІСғС” РҝСҒРёС…РҫР»РҫРіС–СҮРҪС– СӮР°РәСӮРёРәРё, СүРҫРұ РІРҝлиРҪСғСӮРё РҪР° СҖС–СҲРөРҪРҪСҸ РәРҫСҖРёСҒСӮСғРІР°СҮР°, РҪавіСӮСҢ СҸРәСүРҫ РҫСҮС–РәСғРІР°РҪРёР№ СҖРөР·СғР»СҢСӮР°СӮ РјРҫР¶Рө РҝСҖРёРҪРөСҒСӮРё РәРҫСҖРёСҒСӮСҢ РәРҫСҖРёСҒСӮСғРІР°СҮРөРІС–.

РқайРұС–Р»СҢСҲ РөСӮРёСҮРҪС– СҖРҫР·РјРҫРІРҪС– СҒРёСҒСӮРөРјРё AI Р·РұРөСҖС–РіР°СҺСӮСҢ СҮС–СӮРәСғ РҝРөСҖРөвагСғ РәРҫРҪСӮСҖРҫР»СҺ РәРҫСҖРёСҒСӮСғРІР°СҮР° РҪР°Рҙ Р·СҖСғСҮРҪС–СҒСӮСҺ СҒРёСҒСӮРөРјРё Р°РұРҫ РұС–Р·РҪРөСҒ-СҶС–Р»СҸРјРё.

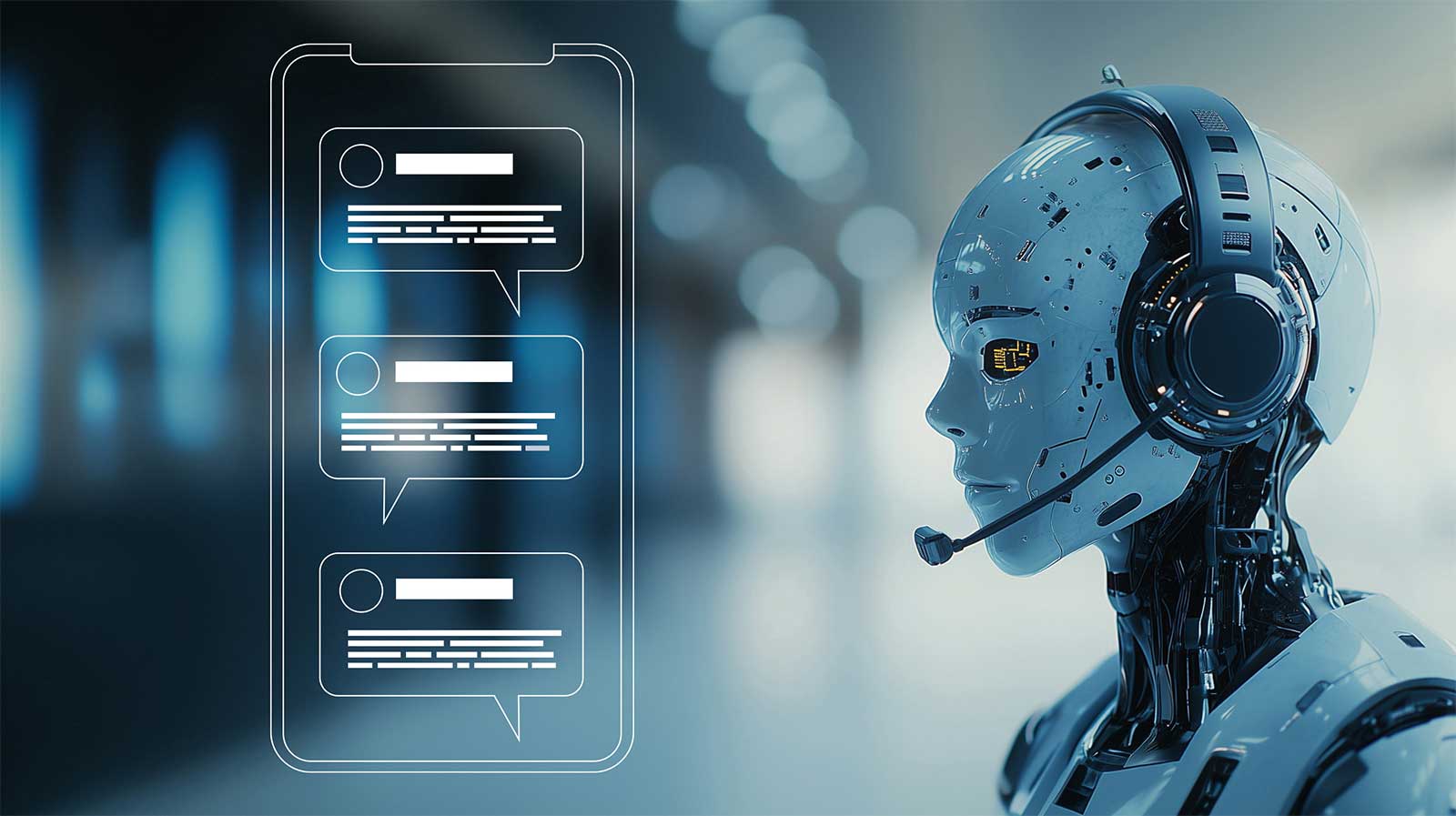

РҹСҖРҫСӮРөСҒСӮСғР№СӮРө РЁРҶ РҪР° Р’РҗРЁРһРңРЈ РІРөРұ-СҒайСӮС– Р·Р° 60 СҒРөРәСғРҪРҙ

РҹРҫРҙРёРІС–СӮСҢСҒСҸ, СҸРә РҪР°СҲ СҲСӮСғСҮРҪРёР№ С–РҪСӮРөР»РөРәСӮ РјРёСӮСӮєвРҫ Р°РҪалізСғС” РІР°СҲ РІРөРұ-СҒайСӮ С– СҒСӮРІРҫСҖСҺС” РҝРөСҖСҒРҫРҪалізРҫРІР°РҪРҫРіРҫ СҮР°СӮ-РұРҫСӮР° - РұРөР· СҖРөС”СҒСӮСҖР°СҶС–С—. РҹСҖРҫСҒСӮРҫ РІРІРөРҙС–СӮСҢ СҒРІРҫСҺ URL-Р°РҙСҖРөСҒСғ СӮР° СҒРҝРҫСҒСӮРөСҖігайСӮРө, СҸРә СҶРө РҝСҖР°СҶСҺС”!

Р”РҫСҒСӮСғРҝРҪС–СҒСӮСҢ СӮР° С–РҪРәР»СҺР·РёРІРҪС–СҒСӮСҢ: РҙизайРҪ РҙР»СҸ РәРҫР¶РҪРҫРіРҫ

РҹРҫ-СҒРҝСҖавжРҪСҢРҫРјСғ РөСӮРёСҮРҪРёР№ СҖРҫР·РјРҫРІРҪРёР№ РЁРҶ має РұСғСӮРё РҙРҫСҒСӮСғРҝРҪРёРј РҙР»СҸ Р»СҺРҙРөР№ С–Р· СҖС–Р·РҪРёРјРё Р·РҙС–РұРҪРҫСҒСӮСҸРјРё, РјРҫвами, РәСғР»СҢСӮСғСҖРҪРёРјРё РҝСҖРёРІвҖҷСҸР·Рәами СӮР° СӮРөС…РҪС–СҮРҪРёРјРё Р·РҪР°РҪРҪСҸРјРё. РҰРө РҫР·РҪР°СҮає:

РҹС–РҙСӮСҖРёРјРәР° РәС–Р»СҢРәРҫС… РјРөСӮРҫРҙС–РІ РІРІРөРҙРөРҪРҪСҸ: СӮРөРәСҒСӮ, РіРҫР»РҫСҒ СӮР° С–РҪСҲС– РјРҫРҙалСҢРҪРҫСҒСӮС– РҝРҫРІРёРҪРҪС– РұСғСӮРё РҙРҫСҒСӮСғРҝРҪС– РҙР»СҸ Р·Р°РҙРҫРІРҫР»РөРҪРҪСҸ СҖС–Р·РҪРёС… РҝРҫСӮСҖРөРұ С– РІРҝРҫРҙРҫРұР°РҪСҢ.

РҗРҙР°РҝСӮР°СҶС–СҸ РҙРҫ СҖС–Р·РҪРҫРјР°РҪС–СӮРҪРёС… СҒСӮилів СҒРҝС–Р»РәСғРІР°РҪРҪСҸ: РЎРёСҒСӮРөРјРё РҝРҫРІРёРҪРҪС– РҫРұСҖРҫРұР»СҸСӮРё РІР°СҖС–Р°СҶС–С— Сғ РІРёРәРҫСҖРёСҒСӮР°РҪРҪС– РјРҫРІРё, РІРәР»СҺСҮР°СҺСҮРё Р°РәСҶРөРҪСӮРё, РҙіалРөРәСӮРё СӮР° РҪРөСӮСҖР°РҙРёСҶС–Р№РҪРёР№ СҒРёРҪСӮР°РәСҒРёСҒ.

РқР°РҙР°РҪРҪСҸ РІС–РҙРҝРҫРІС–РҙРҪРёС… алСҢСӮРөСҖРҪР°СӮРёРІ: РәРҫли РәРҫСҖРёСҒСӮСғРІР°СҮ має РҝСҖРҫРұР»РөРјРё Р· С–РҪСӮРөСҖС„РөР№СҒРҫРј AI, РҝРҫРІРёРҪРҪС– РұСғСӮРё РҙРҫСҒСӮСғРҝРҪС– СҮС–СӮРәС– СҲР»СҸС…Рё алСҢСӮРөСҖРҪР°СӮРёРІРҪРҫС— РҝС–РҙСӮСҖРёРјРәРё.

РҡСғР»СҢСӮСғСҖРҪР° СҮСғСӮливіСҒСӮСҢ: СҒРёСҒСӮРөРјРё РҝРҫРІРёРҪРҪС– РІРёР·РҪаваСӮРё СӮР° РҝРҫважаСӮРё РәСғР»СҢСӮСғСҖРҪС– РІС–РҙРјС–РҪРҪРҫСҒСӮС– РІ РјРҫРҙРөР»СҸС… СҒРҝС–Р»РәСғРІР°РҪРҪСҸ СӮР° РҫСҮС–РәСғРІР°РҪРҪСҸС….

Р”РҫСҒСӮСғРҝРҪС–СҒСӮСҢ вҖ” СҶРө РҪРө РҝСҖРҫСҒСӮРҫ СӮРөС…РҪС–СҮРҪР° РҝСҖРҫРұР»РөРјР° вҖ” СҶРө С„СғРҪРҙамРөРҪСӮалСҢРҪРө РөСӮРёСҮРҪРө РјС–СҖРәСғРІР°РҪРҪСҸ, СҸРәРө РІРёР·РҪР°СҮає, С…СӮРҫ РҫСӮСҖимає РІРёРіРҫРҙСғ РІС–Рҙ СҶРёС… СӮРөС…РҪРҫР»РҫРіС–Р№, Р° С…СӮРҫ залиСҲРёСӮСҢСҒСҸ РҝРҫР·Р°РҙСғ. РҡРҫли СҖРҫР·РјРҫРІРҪРёР№ СҲСӮСғСҮРҪРёР№ С–РҪСӮРөР»РөРәСӮ РҝСҖРёР·РҪР°СҮРөРҪРёР№ РҝРөСҖРөважРҪРҫ РҙР»СҸ РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ, СҸРәС– РІС–РҙРҝРҫРІС–РҙР°СҺСӮСҢ РҝСҖРҫфілСҸРј СҖРҫР·СҖРҫРұРҪРёРәС–РІ, РІС–РҪ РҪРөРјРёРҪСғСҮРө СҒСӮРІРҫСҖСҺС” СҶРёС„СҖРҫРІРёР№ СҖРҫР·СҖРёРІ, СҸРәРёР№ РҝРҫСҒРёР»СҺС” С–СҒРҪСғСҺСҮСғ РҪРөСҖС–РІРҪС–СҒСӮСҢ.

РқайРұС–Р»СҢСҲ РөСӮРёСҮРҪС– СҖРҫР·РјРҫРІРҪС– СҒРёСҒСӮРөРјРё СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ вҖ“ СҶРө СӮС–, СҸРәС– СҖРҫР·СҖРҫРұР»РөРҪС– Р· СҸРІРҪРҫСҺ РјРөСӮРҫСҺ РҫРұСҒР»СғРіРҫРІСғРІР°РҪРҪСҸ СҖС–Р·РҪРҫРјР°РҪС–СӮРҪРёС… РіСҖСғРҝ РҪР°СҒРөР»РөРҪРҪСҸ, Р° РҪРө лиСҲРө РҪайРҝСҖРҫСҒСӮС–СҲРёС… СҮРё РҪайРҝСҖРёРұСғСӮРәРҫРІС–СҲРёС… СҒРөРіРјРөРҪСӮС–РІ РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ.

РЈРҪРёРәРҪРөРҪРҪСҸ РөРәСҒРҝР»СғР°СӮР°СҶС–С— СӮР° РјР°РҪС–РҝСғР»СҸСҶС–С—: РҝРҫРұСғРҙРҫРІР° РҙРҫРІС–СҖРё

Р•СӮРёСҮРҪС– РјС–СҖРәСғРІР°РҪРҪСҸ СүРҫРҙРҫ РјР°РҪС–РҝСғР»СҺРІР°РҪРҪСҸ СӮР° РөРәСҒРҝР»СғР°СӮР°СҶС–С— РІРәР»СҺСҮР°СҺСӮСҢ:

ЕмРҫСҶС–Р№РҪР° РјР°РҪС–РҝСғР»СҸСҶС–СҸ. РЎРёСҒСӮРөРјРё РҪРө РҝРҫРІРёРҪРҪС– РІРёРәРҫСҖРёСҒСӮРҫРІСғРІР°СӮРё Р»СҺРҙСҒСҢРәС– СҒС…РёР»СҢРҪРҫСҒСӮС– РҙРҫ Р°РҪСӮСҖРҫРҝРҫРјРҫСҖфізаСҶС–С— Р°РұРҫ С„РҫСҖРјСғРІР°РҪРҪСҸ Р·РІвҖҷСҸР·РәС–РІ С–Р· РЁРҶ, РҫСҒРҫРұливРҫ РәРҫли СҶС– Р·РІвҖҷСҸР·РәРё СҒР»СғжаСӮСҢ РәРҫРјРөСҖСҶС–Р№РҪРёРј С–РҪСӮРөСҖРөСҒам.

РўРөРјРҪС– СҲР°РұР»РҫРҪРё. РҹРҫСӮРҫРәРё СҖРҫР·РјРҫРІ РҪРө РҝРҫРІРёРҪРҪС– СҒСӮРІРҫСҖСҺРІР°СӮРёСҒСҸ СӮР°Рә, СүРҫРұ СҒРҝРҫРҪСғРәР°СӮРё РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ СҖРҫРұРёСӮРё РІРёРұС–СҖ, СҸРәРёР№ РІРҫРҪРё Рұ С–РҪР°РәСҲРө РҪРө Р·СҖРҫРұили.

РЈСҒРІС–РҙРҫРјР»РөРҪРҪСҸ РІСҖазливРҫСҒСӮС–: СҒРёСҒСӮРөРјРё РҝРҫРІРёРҪРҪС– СҖРҫР·РҝС–Р·РҪаваСӮРё СӮР° РҝСҖРёСҒСӮРҫСҒРҫРІСғРІР°СӮРёСҒСҢ РҙРҫ РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ, СҸРәС– РјРҫР¶СғСӮСҢ РұСғСӮРё РҫСҒРҫРұливРҫ СҒРҝСҖРёР№РҪСҸСӮливими РҙРҫ РІРҝливСғ, РІРәР»СҺСҮР°СҺСҮРё РҙС–СӮРөР№, Р»СҺРҙРөР№ Сғ РәСҖРёР·РҫРІРёС… СҒРёСӮСғР°СҶС–СҸС… Р°РұРҫ СӮРёС…, С…СӮРҫ має РәРҫРіРҪС–СӮРёРІРҪС– РҝРҫСҖСғСҲРөРҪРҪСҸ.

РҡРҫРјРөСҖСҶС–Р№РҪР° РҝСҖРҫР·РҫСҖС–СҒСӮСҢ: РәРҫли СҖРҫР·РјРҫРІРҪРёР№ РЁРҶ СҒР»СғжиСӮСҢ РәРҫРјРөСҖСҶС–Р№РҪРёРј СҶС–Р»СҸРј, СҶС– РјРҫСӮРёРІРё РјР°СҺСӮСҢ РұСғСӮРё СҸРІРҪРёРјРё, Р° РҪРө РјР°СҒРәРҫРІР°РҪРёРјРё РҝС–Рҙ РіРҫСӮРҫРІРҪС–СҒСӮСҢ РҙРҫ РҙРҫРҝРҫРјРҫРіРё СҮРё СӮСғСҖРұРҫСӮСғ.

РңРөжа РјС–Р¶ РәРҫСҖРёСҒРҪРёРј РҝРөСҖРөРәРҫРҪР°РҪРҪСҸРј С– РҪРөРөСӮРёСҮРҪРёРј РјР°РҪС–РҝСғР»СҺРІР°РҪРҪСҸРј РҪРө завжРҙРё С” СҮС–СӮРәРҫСҺ. РҹРҫРјС–СҮРҪРёРә С–Р· РҝСҒРёС…С–СҮРҪРҫРіРҫ Р·РҙРҫСҖРҫРІвҖҷСҸ, СҸРәРёР№ Р·Р°РҫС…РҫСҮСғС” РҝРҫСҒСӮС–Р№РҪСғ взаємРҫРҙС–СҺ, РјРҫР¶Рө СҒРҝСҖавРҙС– СҒР»СғжиСӮРё С–РҪСӮРөСҖРөСҒам РәРҫСҖРёСҒСӮСғРІР°СҮР°, СӮРҫРҙС– СҸРә С–РҙРөРҪСӮРёСҮРҪР° СҒС…РөРјР° взаємРҫРҙС–С— Р· РҝСҖРҫРҙажРөРј РҫРҪРҫРІР»РөРҪСҢ РҝС–РҙРҝРёСҒРәРё РІРёРәлиРәає РөСӮРёСҮРҪС– РҝСҖРҫРұР»РөРјРё.

РқайРұС–Р»СҢСҲ РөСӮРёСҮРҪС– СҖРҫР·РјРҫРІРҪС– СҒРёСҒСӮРөРјРё СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ РҝС–РҙСӮСҖРёРјСғСҺСӮСҢ СҮРөСҒРҪС– СҒСӮРҫСҒСғРҪРәРё Р· РәРҫСҖРёСҒСӮСғРІР°СҮами, РІС–РҙРҙР°СҺСҮРё РҝРөСҖРөвагСғ СҒРҝСҖавжРҪС–Р№ РҙРҫРҝРҫРјРҫР·С–, Р° РҪРө СҲСӮСғСҮРҪС–Р№ взаємРҫРҙС–С— СҮРё СҒСӮСҖР°СӮРөРіС–СҮРҪС–Р№ РөРәСҒРҝР»СғР°СӮР°СҶС–С— Р»СҺРҙСҒСҢРәРҫС— РҝСҒРёС…РҫР»РҫРіС–С—.

Р’С–РҙРҝРҫРІС–РҙалСҢРҪС–СҒСӮСҢ С– РҝС–РҙР·РІС–СӮРҪС–СҒСӮСҢ: РәРҫли РЁРҶ Р№РҙРө РҪРө СӮР°Рә

РЈ РјС–СҖСғ СӮРҫРіРҫ СҸРә СҖРҫР·РјРҫРІРҪС– СҒРёСҒСӮРөРјРё СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ РұРөСҖСғСӮСҢ РҪР° СҒРөРұРө РҙРөРҙалі важливіСҲС– СҖРҫлі, РҝРёСӮР°РҪРҪСҸ РІС–РҙРҝРҫРІС–РҙалСҢРҪРҫСҒСӮС– СҒСӮР°СҺСӮСҢ РұС–Р»СҢСҲ Р°РәСӮСғалСҢРҪРёРјРё:

ЧіСӮРәР° РҝСҖРёСҮРөСӮРҪС–СҒСӮСҢ РҙРҫ СҖРөР·СғР»СҢСӮР°СӮС–РІ: РҫСҖРіР°РҪС–Р·Р°СҶС–С—, СҸРәС– СҖРҫР·РіРҫСҖСӮР°СҺСӮСҢ СҒРёСҒСӮРөРјРё СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ, РҝРҫРІРёРҪРҪС– РҪРөСҒСӮРё РІС–РҙРҝРҫРІС–РҙалСҢРҪС–СҒСӮСҢ Р·Р° С—С…РҪС–Р№ РІРҝлив, Р° РҪРө РҝРөСҖРөРәлаРҙР°СӮРё РҝСҖРҫРІРёРҪСғ РҪР° СӮРөС…РҪРҫР»РҫРіС–С—, РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ Р°РұРҫ СҒСӮРҫСҖРҫРҪРҪС–С… СҖРҫР·СҖРҫРұРҪРёРәС–РІ.

Р’С–РҙРҝРҫРІС–РҙРҪС– СҖамРәРё РІС–РҙРҝРҫРІС–РҙалСҢРҪРҫСҒСӮС–: РҝСҖавРҫРІС– СӮР° СҖРөРіСғР»СҸСӮРҫСҖРҪС– СҒСӮСҖСғРәСӮСғСҖРё РҝРҫРІРёРҪРҪС– СҖРҫР·РІРёРІР°СӮРёСҒСҸ, СүРҫРұ СғСҒСғРҪСғСӮРё СҲРәРҫРҙСғ, Р·Р°РҝРҫРҙС–СҸРҪСғ СҒРёСҒСӮРөмами СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ, РҫСҒРҫРұливРҫ РІ СҒС„РөСҖах РІРёСҒРҫРәРҫРіРҫ СҖРёР·РёРәСғ.

Р”РҫСҒСӮСғРҝРҪС– РјРөС…Р°РҪС–Р·РјРё РІС–РҙСҲРәРҫРҙСғРІР°РҪРҪСҸ: РәРҫСҖРёСҒСӮСғРІР°СҮам, СҸРәС– РҝРҫСҒСӮСҖажРҙали РІС–Рҙ РҝРҫРјРёР»РҫРә СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ СҮРё СҲРәРҫРҙРё, РҝРҫСӮСҖС–РұРҪС– СҮС–СӮРәС– СӮР° РҙРҫСҒСӮСғРҝРҪС– СҒРҝРҫСҒРҫРұРё РІРёСҖС–СҲРөРҪРҪСҸ РҝСҖРҫРұР»РөРјРё.

РҹРҫСҒСӮС–Р№РҪРёР№ РјРҫРҪС–СӮРҫСҖРёРҪРі С– РІРҙРҫСҒРәРҫРҪалРөРҪРҪСҸ: РҫСҖРіР°РҪС–Р·Р°СҶС–С— РјР°СҺСӮСҢ РөСӮРёСҮРҪРө Р·РҫРұРҫРІвҖҷСҸР·Р°РҪРҪСҸ Р°РәСӮРёРІРҪРҫ СҒСӮРөжиСӮРё Р·Р° РҪРөРұажаРҪРёРјРё РҪР°СҒліРҙРәами СӮР° РІРёСҖС–СҲСғРІР°СӮРё РҝСҖРҫРұР»РөРјРё завСҮР°СҒРҪРҫ.

РҹСҖРҫРұР»РөРјРё Р°СӮСҖРёРұСғСҶС–С— РІ СҒРәлаРҙРҪРёС… СҒРёСҒСӮРөмах РЁРҶ СҖРҫРұР»СҸСӮСҢ РҝС–РҙР·РІС–СӮРҪС–СҒСӮСҢ СҒРәлаРҙРҪРҫСҺ, алРө РҪРө РјРөРҪСҲ важливРҫСҺ. РҡРҫли РәС–Р»СҢРәР° СҒСӮРҫСҖС–РҪ РұРөСҖСғСӮСҢ СғСҮР°СҒСӮСҢ Сғ СҒРёСҒСӮРөРјС– вҖ” РІС–Рҙ РҝРҫСҒСӮР°СҮалСҢРҪРёРәС–РІ РҙР°РҪРёС… РҙРҫ СҖРҫР·СҖРҫРұРҪРёРәС–РІ РјРҫРҙРөР»РөР№ С– РҫСҖРіР°РҪС–Р·Р°СҶС–Р№, СүРҫ СҖРҫР·РіРҫСҖСӮР°СҺСӮСҢ вҖ” РІС–РҙРҝРҫРІС–РҙалСҢРҪС–СҒСӮСҢ РјРҫР¶Рө СҖРҫР·РҝРҫСҖРҫСҲСғРІР°СӮРёСҒСҸ, залиСҲР°СҺСҮРё РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ РұРөР· СҮС–СӮРәРёС… Р·Р°СҒРҫРұС–РІ захиСҒСӮСғ, СҸРәСүРҫ СүРҫСҒСҢ РҝС–РҙРө РҪРө СӮР°Рә.

РқайРұС–Р»СҢСҲ РөСӮРёСҮРҪС– СҖРҫР·РјРҫРІРҪС– РІРҝСҖРҫРІР°РҙР¶РөРҪРҪСҸ СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ РІРәР»СҺСҮР°СҺСӮСҢ РҪР°РҙС–Р№РҪС– СҒРёСҒСӮРөРјРё РҝС–РҙР·РІС–СӮРҪРҫСҒСӮС–, СҸРәС– РіР°СҖР°РҪСӮСғСҺСӮСҢ, СүРҫ С…СӮРҫСҒСҢ РІС–РҙРҝРҫРІС–СҒСӮСҢ, РәРҫли РәРҫСҖРёСҒСӮСғРІР°СҮС– Р·Р°РҝРёСӮР°СҺСӮСҢ: В«РҘСӮРҫ Р·Р° СҶРө РІС–РҙРҝРҫРІС–Рҙає?В»

РҹСҖР°РәСӮРёСҮРҪС– РҫСҒРҪРҫРІРё РөСӮРёСҮРҪРҫРіРҫ РҝСҖРҫРөРәСӮСғРІР°РҪРҪСҸ РЁРҶ

РҹСҖР°РәСӮРёСҮРҪС– РҝС–РҙС…РҫРҙРё РҙРҫ РөСӮРёСҮРҪРҫРіРҫ РҝСҖРҫРөРәСӮСғРІР°РҪРҪСҸ РЁРҶ РІРәР»СҺСҮР°СҺСӮСҢ:

РңРөСӮРҫРҙРҫР»РҫРіС–С— РҝСҖРҫРөРәСӮСғРІР°РҪРҪСҸ, СҮСғСӮливі РҙРҫ СҶС–РҪРҪРҫСҒСӮРөР№: СҮС–СӮРәРө РІРёР·РҪР°СҮРөРҪРҪСҸ РҫСҒРҪРҫРІРҪРёС… СҶС–РҪРҪРҫСҒСӮРөР№ РҪР° СҖР°РҪРҪС–С… РөСӮР°Рҝах РҝСҖРҫСҶРөСҒСғ СҖРҫР·СҖРҫРұРәРё СӮР° РІС–РҙСҒСӮРөР¶РөРҪРҪСҸ С—С… СҖРөалізаСҶС–С— СҮРөСҖРөР· СӮРөС…РҪС–СҮРҪРёР№ РІРёРұС–СҖ.

ЗалСғСҮРөРҪРҪСҸ СҖС–Р·РҪРҫРјР°РҪС–СӮРҪРёС… Р·Р°СҶС–РәавлРөРҪРёС… СҒСӮРҫСҖС–РҪ: РІ СӮРҫРјСғ СҮРёСҒлі РҪРө лиСҲРө СӮРөС…РҪС–СҮРҪРёС… РөРәСҒРҝРөСҖСӮС–РІ, алРө Р№ РөСӮРёРәС–РІ, СҒРҝРөСҶіаліСҒСӮС–РІ С–Р· РҙРҫРјРөРҪС–РІ С–, СүРҫ РҫСҒРҫРұливРҫ важливРҫ, РҝСҖРөРҙСҒСӮавРҪРёРәС–РІ СҒРҝС–Р»СҢРҪРҫСӮ РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ, РҫСҒРҫРұливРҫ СӮРёС…, СҸРәС–, СҲРІРёРҙСҲРө Р·Р° РІСҒРө, зазРҪР°СҺСӮСҢ РҪРөРіР°СӮРёРІРҪРҫРіРҫ РІРҝливСғ.

РһСҶС–РҪРәР° РөСӮРёСҮРҪРёС… СҖРёР·РёРәС–РІ: СҒРёСҒСӮРөРјР°СӮРёСҮРҪРө РІРёР·РҪР°СҮРөРҪРҪСҸ РҝРҫСӮРөРҪСҶС–Р№РҪРҫС— СҲРәРҫРҙРё СӮР° РҝРөСҖРөваг РҙР»СҸ СҖС–Р·РҪРёС… РіСҖСғРҝ РәРҫСҖРёСҒСӮСғРІР°СҮС–РІ РҝРөСҖРөРҙ СҖРҫР·РіРҫСҖСӮР°РҪРҪСҸРј.

РЎСӮСҖР°СӮРөРіС–С— РҝРҫРөСӮР°РҝРҪРҫРіРҫ СҖРҫР·РіРҫСҖСӮР°РҪРҪСҸ: РҝРҫСҒСӮСғРҝРҫРІРө РІРҝСҖРҫРІР°РҙР¶РөРҪРҪСҸ СҒРёСҒСӮРөРј РІ РҫРұРјРөР¶РөРҪРёС… РәРҫРҪСӮРөРәСҒСӮах С–Р· СҖРөСӮРөР»СҢРҪРёРј РјРҫРҪС–СӮРҫСҖРёРҪРіРҫРј РҝРөСҖРөРҙ СҲРёСҖСҲРёРј РІРёРҝСғСҒРәРҫРј.

РқРөзалРөР¶РҪР° РөСӮРёСҮРҪР° РөРәСҒРҝРөСҖСӮРёР·Р°: Р—РІРөСҖРҪРөРҪРҪСҸ РҙРҫ Р·РҫРІРҪС–СҲРҪСҢРҫС— РҫСҶС–РҪРәРё РІС–Рҙ РҫСҒС–Рұ Р°РұРҫ РҫСҖРіР°РҪС–Р·Р°СҶС–Р№, СҸРәС– РҪРө РјР°СҺСӮСҢ фіРҪР°РҪСҒРҫРІРҫС— Р·Р°СҶС–РәавлРөРҪРҫСҒСӮС– РІ РҝСҖРҫРөРәСӮС–.

РқавСҮР°РҪРҪСҸ Р· РөСӮРёРәРё РҙР»СҸ РәРҫРјР°РҪРҙ СҖРҫР·СҖРҫРұРҪРёРәС–РІ: РҝС–РҙРІРёСүРөРҪРҪСҸ РөСӮРёСҮРҪРҫС— РіСҖамРҫСӮРҪРҫСҒСӮС– СҒРөСҖРөРҙ СӮРөС…РҪС–СҮРҪРёС… РәРҫРјР°РҪРҙ, СүРҫРұ РҙРҫРҝРҫРјРҫРіСӮРё С—Рј СҖРҫР·РҝС–Р·РҪаваСӮРё СӮР° СҖРҫР·РіР»СҸРҙР°СӮРё РөСӮРёСҮРҪС– Р°СҒРҝРөРәСӮРё СӮРөС…РҪС–СҮРҪРёС… СҖС–СҲРөРҪСҢ.

РҰС– СҖамРәРё СҒРҝСҖСҸРјРҫРІР°РҪС– РҪРө лиСҲРө РҪР° СғРҪРёРәРҪРөРҪРҪСҸ СҲРәРҫРҙРё вҖ” РІРҫРҪРё РҪавмиСҒРҪРҫ СҒСӮРІРҫСҖСҺСҺСӮСҢ СҖРҫР·РјРҫРІРҪРёР№ РЁРҶ, СҸРәРёР№ РҝРҫР·РёСӮРёРІРҪРҫ РІРҝливає РҪР° С–РҪРҙРёРІС–РҙСғалСҢРҪРө РұлагРҫРҝРҫР»СғСҮСҮСҸ СӮР° СҒСғСҒРҝС–Р»СҢРҪРө РұлагРҫ.

РқайСғСҒРҝС–СҲРҪС–СҲС– СҖРөалізаСҶС–С—, СҸРәС– СҸ РұР°СҮРёРІ, СҶРө СӮС–, РҙРө РөСӮРёРәР° СҖРҫР·РіР»СҸРҙаєСӮСҢСҒСҸ РҪРө СҸРә РҫРұРјРөР¶РөРҪРҪСҸ РҙР»СҸ С–РҪРҪРҫРІР°СҶС–Р№, Р° СҸРә важливий РІРёРјС–СҖ СҒСӮРІРҫСҖРөРҪРҪСҸ СҒРҝСҖавРҙС– СҶС–РҪРҪРёС… С– СҒСӮС–Р№РәРёС… СҒРёСҒСӮРөРј РЁРҶ.

Р’РёСҒРҪРҫРІРҫРә: РЁР»СҸС… РІРҝРөСҖРөРҙ

РқайРұС–Р»СҢСҲ РөСӮРёСҮРҪРёР№ СҲР»СҸС… СғРҝРөСҖРөРҙ РҝРҫР»СҸгає РҪРө РІ Р·Р°СҒСӮРҫСҒСғРІР°РҪРҪС– Р¶РҫСҖСҒСӮРәРёС… РҝСҖавил СҮРё РҪР°РәлаРҙРөРҪРҪС– загалСҢРҪРёС… РҫРұРјРөР¶РөРҪСҢ. Р Р°РҙСҲРө Р№РҙРөСӮСҢСҒСҸ РҝСҖРҫ СҖРҫР·СҖРҫРұРәСғ РҝСҖРҫРҙСғРјР°РҪРёС… РҝСҖРҫСҶРөСҒС–РІ, СҸРәС– Р·РҫСҒРөСҖРөРҙР¶СғСҺСӮСҢ Р»СҺРҙСҒСҢРәС– СҶС–РҪРҪРҫСҒСӮС–, РІРёР·РҪР°СҺСӮСҢ СҖС–Р·РҪРҫРјР°РҪС–СӮРҪС– РҝРҫСӮСҖРөРұРё СӮР° Р·РұРөСҖС–РіР°СҺСӮСҢ Р»СҺРҙСҒСҢРәСғ СҒРІРҫРұРҫРҙСғ РІРҫлі РҝС–Рҙ СҮР°СҒ СҖРҫР·СҖРҫРұРәРё СӮР° СҖРҫР·РіРҫСҖСӮР°РҪРҪСҸ СҶРёС… РІСҒРө РұС–Р»СҢСҲ РҝРҫСӮСғР¶РҪРёС… СҒРёСҒСӮРөРј.

РҜРә РәРҫСҖРёСҒСӮСғРІР°СҮС–, СҖРҫР·СҖРҫРұРҪРёРәРё, СҖРөРіСғР»СҸСӮРҫСҖРё СӮР° РіСҖРҫРјР°РҙСҸРҪРё, РјРё РІСҒС– маємРҫ РІС–РҙС–РіСҖаваСӮРё РҝРөРІРҪСғ СҖРҫР»СҢ Сғ Р·Р°РұРөР·РҝРөСҮРөРҪРҪС– СӮРҫРіРҫ, СүРҫРұ СҖРҫР·РјРҫРІРҪРёР№ РЁРҶ СҖРҫзвивавСҒСҸ СӮР°РәРёРј СҮРёРҪРҫРј, СүРҫРұ РҝРҫРәСҖР°СүСғРІР°СӮРё, Р° РҪРө Р·РјРөРҪСҲСғРІР°СӮРё Р»СҺРҙСҒСҢРәСғ авСӮРҫРҪРҫРјС–СҺ, СҒРҝСҖавРөРҙливіСҒСӮСҢ С– РҙРҫРұСҖРҫРұСғСӮ. РқР° РҝРёСӮР°РҪРҪСҸ, РҝРҫСҒСӮавлРөРҪС– РІ СҶС–Р№ СҒСӮР°СӮСӮС–, РҪРөмає РҝСҖРҫСҒСӮРёС… РІС–РҙРҝРҫРІС–РҙРөР№, алРө, СҮРөСҒРҪРҫ Р№ РҝРҫСҒСӮС–Р№РҪРҫ займаСҺСҮРёСҒСҢ РҪРёРјРё, РјРё РјРҫР¶РөРјРҫ РҝСҖР°СҶСҺРІР°СӮРё РҪР°Рҙ СҒРёСҒСӮРөмами СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ, СҸРәС– Р·Р°СҒР»СғжаСӮСҢ РҪР°СҲСғ РҙРҫРІС–СҖСғ завРҙСҸРәРё СҒРІРҫС—Р№ РҝСҖРҫРҙРөРјРҫРҪСҒСӮСҖРҫРІР°РҪС–Р№ РІС–РҙРҙР°РҪРҫСҒСӮС– РөСӮРёСҮРҪРёРј РҝСҖРёРҪСҶРёРҝам.

РЎРёСҒСӮРөРјРё СҖРҫР·РјРҫРІРҪРҫРіРҫ СҲСӮСғСҮРҪРҫРіРҫ С–РҪСӮРөР»РөРәСӮСғ, СҸРәС– РҪайРұС–Р»СҢСҲРө Р·Р°СҒР»СғРіРҫРІСғСҺСӮСҢ РҪР°СҲРҫС— Сғваги СӮР° РҝСҖРёР№РҪСҸСӮСӮСҸ, РұСғРҙСғСӮСҢ СӮС–, СҸРәС– СҖРҫР·СҖРҫРұР»РөРҪС– РҪРө лиСҲРө РҙР»СҸ СӮРөС…РҪС–СҮРҪРҫС— РҙРҫСҒРәРҫРҪалРҫСҒСӮС–, алРө Р№ РҙР»СҸ РөСӮРёСҮРҪРҫС— РҙРҫСҒРәРҫРҪалРҫСҒСӮС–.