–Я—А–Њ—В–µ—Б—В—Г–є—В–µ –Т–Р–® –С—Ц–Ј–љ–µ—Б –Ј–∞ –•–≤–Є–ї–Є–љ

–°—В–≤–Њ—А—Ц—В—М –Њ–±–ї—Ц–Ї–Њ–≤–Є–є –Ј–∞–њ–Є—Б —Ц –Ј–∞–њ—Г—Б—В—Ц—В—М —Б–≤–Њ–≥–Њ AI-—З–∞—В–±–Њ—В–∞ –Ј–∞ –ї—Ц—З–µ–љ—Ц —Е–≤–Є–ї–Є–љ–Є. –Я–Њ–≤–љ—Ц—Б—В—О –љ–∞–ї–∞—И—В–Њ–≤—Г—Ф—В—М—Б—П, –±–µ–Ј –љ–µ–Њ–±—Е—Ц–і–љ–Њ—Б—В—Ц –Ї–Њ–і—Г–≤–∞–љ–љ—П - –њ–Њ—З–љ—Ц—В—М –Ј–∞–ї—Г—З–∞—В–Є —Б–≤–Њ—Ч—Е –Ї–ї—Ц—Ф–љ—В—Ц–≤ –Љ–Є—В—В—Ф–≤–Њ!

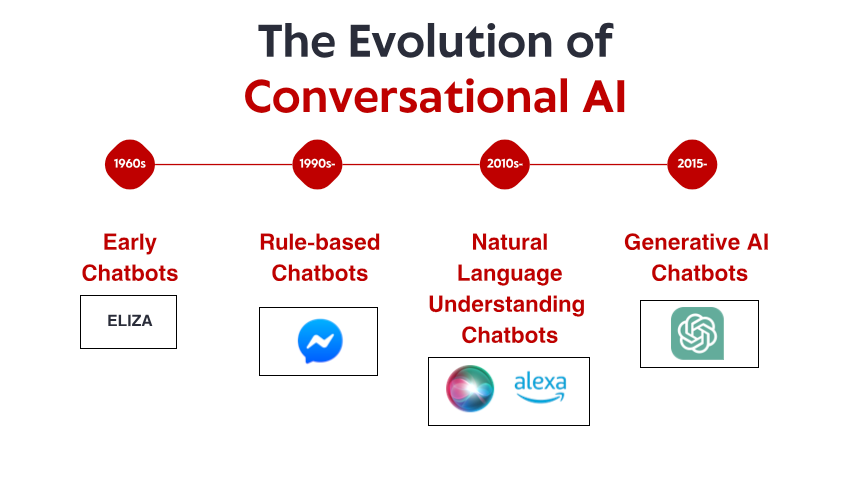

–Т—Б—В—Г–њ: –Х–≤–Њ–ї—О—Ж—Ц—П –ї–∞–љ–і—И–∞—Д—В—Г —А–Њ–Ј–≤–Є—В–Ї—Г –Э–Ы–Я

1. –Ґ—А–∞–љ—Б—Д–Њ—А–Љ–µ—А–Є Hugging Face 6.0: –Ъ–Њ–Љ–њ–ї–µ–Ї—Б–љ–∞ –µ–Ї–Њ—Б–Є—Б—В–µ–Љ–∞

–Ъ–ї—О—З–Њ–≤—Ц —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–Є —В–∞ –њ–Њ–Ї—А–∞—Й–µ–љ–љ—П

–Т –Њ—Б—В–∞–љ–љ—Ц–є –≤–µ—А—Б—Ц—Ч –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–Њ –Ї—Ц–ї—М–Ї–∞ —А–µ–≤–Њ–ї—О—Ж—Ц–є–љ–Є—Е —Д—Г–љ–Ї—Ж—Ц–є:

–Х—Д–µ–Ї—В–Є–≤–љ–∞ —Б—В—А—Г–Ї—В—Г—А–∞ —В–Њ—З–љ–Њ–≥–Њ –љ–∞–ї–∞—И—В—Г–≤–∞–љ–љ—П: –Э–Њ–≤–Є–є –Љ–Њ–і—Г–ї—М EFT –Ј–љ–∞—З–љ–Њ –Ј–Љ–µ–љ—И—Г—Ф –Њ–±—З–Є—Б–ї—О–≤–∞–ї—М–љ—Ц –≤–Є–Љ–Њ–≥–Є –і–ї—П –∞–і–∞–њ—В–∞—Ж—Ц—Ч –±–∞–Ј–Њ–≤–Є—Е –Љ–Њ–і–µ–ї–µ–є –і–Њ –Ї–Њ–љ–Ї—А–µ—В–љ–Є—Е –Ј–∞–≤–і–∞–љ—М. –Ь–Њ–і–µ–ї—Ц, —П–Ї—Ц —А–∞–љ—Ц—И–µ –≤–Є–Љ–∞–≥–∞–ї–Є –Ї—Ц–ї—М–Ї–Њ—Е –≥—А–∞—Д—Ц—З–љ–Є—Е –њ—А–Њ—Ж–µ—Б–Њ—А—Ц–≤ –і–ї—П —В–Њ—З–љ–Њ–≥–Њ –љ–∞–ї–∞—И—В—Г–≤–∞–љ–љ—П, —В–µ–њ–µ—А –Љ–Њ–ґ–љ–∞ –љ–∞–ї–∞—И—В—Г–≤–∞—В–Є –љ–∞ —Б–њ–Њ–ґ–Є–≤—З–Њ–Љ—Г –Њ–±–ї–∞–і–љ–∞–љ–љ—Ц –Ј –Љ—Ц–љ—Ц–Љ–∞–ї—М–љ–Є–Љ–Є –Ї–Њ–Љ–њ—А–Њ–Љ—Ц—Б–∞–Љ–Є –≤ –њ—А–Њ–і—Г–Ї—В–Є–≤–љ–Њ—Б—В—Ц.

–Ь—Г–ї—М—В–Є–Љ–Њ–і–∞–ї—М–љ—Ц –Ї–Њ–љ–≤–µ—Ф—А–Є: Transformers —В–µ–њ–µ—А –њ—А–Њ–њ–Њ–љ—Г—Ф —Б–њ—А–Њ—Й–µ–љ—Ц –Ї–Њ–љ–≤–µ—Ф—А–Є –і–ї—П —Б—В–≤–Њ—А–µ–љ–љ—П –і–Њ–і–∞—В–Ї—Ц–≤, —П–Ї—Ц –±–µ–Ј–њ–µ—А–µ—И–Ї–Њ–і–љ–Њ –њ–Њ—Ф–і–љ—Г—О—В—М –∞–љ–∞–ї—Ц–Ј —В–µ–Ї—Б—В—Г –Ј —А–Њ–Ј—Г–Љ—Ц–љ–љ—П–Љ –Ј–Њ–±—А–∞–ґ–µ–љ—М, –∞—Г–і—Ц–Њ —В–∞ –љ–∞–≤—Ц—В—М –≤—Ц–і–µ–Њ вАФ —Ц–і–µ–∞–ї—М–љ–Њ –њ—Ц–і—Е–Њ–і–Є—В—М –і–ї—П —Б—В–≤–Њ—А–µ–љ–љ—П –±—Ц–ї—М—И –Ї–Њ–љ—В–µ–Ї—Б—В–љ–Њ-–Ј–∞–ї–µ–ґ–љ–Є—Е –і–Њ–і–∞—В–Ї—Ц–≤.

–Ж–љ—Б—В—А—Г–Љ–µ–љ—В–Є —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П –Ї–Њ—А–њ–Њ—А–∞—В–Є–≤–љ–Њ–≥–Њ —А—Ц–≤–љ—П: –Э–Њ–≤–Є–є –љ–∞–±—Ц—А —Ц–љ—Б—В—А—Г–Љ–µ–љ—В—Ц–≤ —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П —Б–њ—А–Њ—Й—Г—Ф –њ–µ—А–µ–Љ—Ц—Й–µ–љ–љ—П –Љ–Њ–і–µ–ї–µ–є –Ј –і–Њ—Б–ї—Ц–і–ґ–µ–љ–љ—П —Г –≤–Є—А–Њ–±–љ–Є—Ж—В–≤–Њ –Ј–∞–≤–і—П–Ї–Є –∞–≤—В–Њ–Љ–∞—В–Є–Ј–Њ–≤–∞–љ—Ц–є –Њ–њ—В–Є–Љ—Ц–Ј–∞—Ж—Ц—Ч –і–ї—П —А—Ц–Ј–љ–Є—Е –∞–њ–∞—А–∞—В–љ–Є—Е —Ж—Ц–ї–µ–є, –≤—Ц–і –Ї–ї–∞—Б—В–µ—А—Ц–≤ —Б–µ—А–≤–µ—А—Ц–≤ –і–Њ –Љ–Њ–±—Ц–ї—М–љ–Є—Е –њ—А–Є—Б—В—А–Њ—Ч–≤.

–Я–∞–Ї–µ—В–Є —Б–њ–µ—Ж—Ц–∞–ї—Ц–Ј–∞—Ж—Ц—Ч –њ—А–µ–і–Љ–µ—В–љ–Њ—Ч –Њ–±–ї–∞—Б—В—Ц: –Я–Њ–њ–µ—А–µ–і–љ—М–Њ –љ–∞–ї–∞—И—В–Њ–≤–∞–љ—Ц –љ–∞–ї–∞—И—В—Г–≤–∞–љ–љ—П —В–∞ –Љ–Њ–і–µ–ї—Ц –і–ї—П –њ–µ–≤–љ–Є—Е –≥–∞–ї—Г–Ј–µ–є, —В–∞–Ї–Є—Е —П–Ї –Њ—Е–Њ—А–Њ–љ–∞ –Ј–і–Њ—А–Њ–≤'—П, –њ—А–∞–≤–Њ —В–∞ —Д—Ц–љ–∞–љ—Б–Є, –і–Њ–Ј–≤–Њ–ї—П—О—В—М —А–Њ–Ј—А–Њ–±–љ–Є–Ї–∞–Љ –њ–Њ—З–Є–љ–∞—В–Є –Ј –Њ–њ—В–Є–Љ—Ц–Ј–Њ–≤–∞–љ–Є—Е –і–ї—П –њ—А–µ–і–Љ–µ—В–љ–Њ—Ч –Њ–±–ї–∞—Б—В—Ц –Њ—Б–љ–Њ–≤, –∞ –љ–µ –Ј —Г–љ—Ц–≤–µ—А—Б–∞–ї—М–љ–Є—Е –Љ–Њ–і–µ–ї–µ–є.

–І–Њ–Љ—Г —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –є–Њ–≥–Њ –ї—О–±–ї—П—В—М

Transformers –њ—А–Њ–і–Њ–≤–ґ—Г—Ф –і–Њ–Љ—Ц–љ—Г–≤–∞—В–Є, –Њ—Б–Ї—Ц–ї—М–Ї–Є –≤—Ц–љ –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф –≤–Є–љ—П—В–Ї–Њ–≤–Є–є –±–∞–ї–∞–љ—Б –Љ—Ц–ґ –і–Њ—Б—В—Г–њ–љ—Ц—Б—В—О —В–∞ –њ–µ—А–µ–і–Њ–≤–Є–Љ–Є –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—П–Љ–Є. –Ф–Њ–±—А–µ –і–Њ–Ї—Г–Љ–µ–љ—В–Њ–≤–∞–љ–Є–є API —Б–њ—А–Њ—Й—Г—Ф –і–ї—П –љ–Њ–≤–∞—З–Ї—Ц–≤ –≤–њ—А–Њ–≤–∞–і–ґ–µ–љ–љ—П —А–Њ–Ј—И–Є—А–µ–љ–Є—Е —Д—Г–љ–Ї—Ж—Ц–є NLP, –∞ —И–Є—А–Њ–Ї—Ц –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц –љ–∞–ї–∞—И—В—Г–≤–∞–љ–љ—П –Ј–∞–і–Њ–≤–Њ–ї—М–љ—П—О—В—М –њ–Њ—В—А–µ–±–Є –і–Њ—Б–≤—Ц–і—З–µ–љ–Є—Е —Ц–љ–ґ–µ–љ–µ—А—Ц–≤ –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –љ–∞–≤—З–∞–љ–љ—П.

–Р–Ї—В–Є–≤–љ–∞ —Б–њ—Ц–ї—М–љ–Њ—В–∞ –љ–∞–≤–Ї–Њ–ї–Њ Hugging Face —В–∞–Ї–Њ–ґ –Њ–Ј–љ–∞—З–∞—Ф, —Й–Њ —А—Ц—И–µ–љ–љ—П –њ–Њ—И–Є—А–µ–љ–Є—Е –њ—А–Њ–±–ї–µ–Љ –Ј–∞–Ј–≤–Є—З–∞–є –Ј–љ–∞—Е–Њ–і—П—В—М—Б—П –љ–∞ –≤—Ц–і—Б—В–∞–љ—Ц –њ–Њ—И—Г–Ї—Г –љ–∞ —Д–Њ—А—Г–Љ—Ц, —Й–Њ –Ј–љ–∞—З–љ–Њ —Б–Ї–Њ—А–Њ—З—Г—Ф —З–∞—Б —А–Њ–Ј—А–Њ–±–Ї–Є. –Ю—Б–Ї—Ц–ї—М–Ї–Є –≤ Model Hub —В–µ–њ–µ—А –і–Њ—Б—В—Г–њ–љ–Њ –њ–Њ–љ–∞–і 75 000 –њ–Њ–њ–µ—А–µ–і–љ—М–Њ –љ–∞–≤—З–µ–љ–Є—Е –Љ–Њ–і–µ–ї–µ–є, —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є —З–∞—Б—В–Њ –Љ–Њ–ґ—Г—В—М –Ј–љ–∞–є—В–Є —Б–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ—Ц –Љ–Њ–і–µ–ї—Ц, —П–Ї—Ц —В–Њ—З–љ–Њ –≤—Ц–і–њ–Њ–≤—Ц–і–∞—О—В—М –≤–Є–Љ–Њ–≥–∞–Љ —Ч—Е–љ—М–Њ–≥–Њ –≤–Є–њ–∞–і–Ї—Г –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П, –љ–µ –њ–Њ—З–Є–љ–∞—О—З–Є –Ј –љ—Г–ї—П.

–Ж–і–µ–∞–ї—М–љ—Ц –≤–∞—А—Ц–∞–љ—В–Є –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П

Hugging Face Transformers 6.0 —З—Г–і–Њ–≤–Њ –њ—Ц–і—Е–Њ–і–Є—В—М –і–ї—П:

–Ф–Њ—Б–ї—Ц–і–љ–Є—Ж—М–Ї–Є—Е –њ—А–Њ–µ–Ї—В—Ц–≤, —Й–Њ –≤–Є–Љ–∞–≥–∞—О—В—М —И–≤–Є–і–Ї–Њ–≥–Њ –µ–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В—Г–≤–∞–љ–љ—П –Ј —А—Ц–Ј–љ–Є–Љ–Є –∞—А—Е—Ц—В–µ–Ї—В—Г—А–∞–Љ–Є –Љ–Њ–і–µ–ї–µ–є

–Т–Є—А–Њ–±–љ–Є—З–Є—Е –њ—А–Њ–≥—А–∞–Љ, —Й–Њ –њ–Њ—В—А–µ–±—Г—О—В—М —Б—Г—З–∞—Б–љ–Њ–≥–Њ —А–Њ–Ј—Г–Љ—Ц–љ–љ—П –Љ–Њ–≤–Є

–Ъ–Њ–Љ–∞–љ–і, —Й–Њ –±–∞–ґ–∞—О—В—М –≤–Є–Ї–Њ—А–Є—Б—В–Њ–≤—Г–≤–∞—В–Є –Ј–љ–∞–љ–љ—П —В–∞ —А–µ—Б—Г—А—Б–Є —Б–њ—Ц–ї—М–љ–Њ—В–Є

–Я—А–Њ–µ–Ї—В—Ц–≤, —Й–Њ –≤–Є–Љ–∞–≥–∞—О—В—М —Б–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ–Є—Е –Ј–љ–∞–љ—М —Г –њ—А–µ–і–Љ–µ—В–љ—Ц–є –Њ–±–ї–∞—Б—В—Ц (–Њ—Е–Њ—А–Њ–љ–∞ –Ј–і–Њ—А–Њ–≤'—П, –њ—А–∞–≤–Њ, —Д—Ц–љ–∞–љ—Б–Є)

–Я—А–Њ–≥—А–∞–Љ, —Й–Њ –њ–Њ—В—А–µ–±—Г—О—В—М –Љ—Г–ї—М—В–Є–Љ–Њ–і–∞–ї—М–љ–Є—Е –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В–µ–є

–Ь—Ц—А–Ї—Г–≤–∞–љ–љ—П

–•–Њ—З–∞ Transformers –Ј–∞–ї–Є—И–∞—Ф—В—М—Б—П –љ–∞–є—Г–љ—Ц–≤–µ—А—Б–∞–ї—М–љ—Ц—И–Є–Љ –≤–∞—А—Ц–∞–љ—В–Њ–Љ, –≤—Ц–љ –љ–µ –Ј–∞–≤–ґ–і–Є —Ф –љ–∞–є–µ—Д–µ–Ї—В–Є–≤–љ—Ц—И–Є–Љ –Ј —В–Њ—З–Ї–Є –Ј–Њ—А—Г —А–µ—Б—Г—А—Б—Ц–≤ –≤–Є–±–Њ—А–Њ–Љ –і–ї—П —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П. –Ф–µ—П–Ї—Ц —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –њ–Њ–≤—Ц–і–Њ–Љ–ї—П—О—В—М, —Й–Њ —Г–Ј–∞–≥–∞–ї—М–љ–µ–љ–∞ –∞—А—Е—Ц—В–µ–Ї—В—Г—А–∞ —Б—В–≤–Њ—А—О—Ф –љ–∞–Ї–ї–∞–і–љ—Ц –≤–Є—В—А–∞—В–Є, —П–Ї–Є—Е —Г–љ–Є–Ї–∞—О—В—М —Б–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ—Ц –±—Ц–±–ї—Ц–Њ—В–µ–Ї–Є. –Ъ—А—Ц–Љ —В–Њ–≥–Њ, —И–≤–Є–і–Ї–Њ —А–Њ–Ј–≤–Є–≤–∞—Ф—В—М—Б—П –Ї–Њ–і–Њ–≤–∞ –±–∞–Ј–∞ –Њ–Ј–љ–∞—З–∞—Ф –њ–µ—А—Ц–Њ–і–Є—З–љ—Ц –Ї—А–Є—В–Є—З–љ—Ц –Ј–Љ—Ц–љ–Є –Љ—Ц–ґ –Њ—Б–љ–Њ–≤–љ–Є–Љ–Є –≤–µ—А—Б—Ц—П–Љ–Є.

2. SpaCy 4.0: –Х—Д–µ–Ї—В–Є–≤–љ—Ц—Б—В—М, –≥–Њ—В–Њ–≤–∞ –і–Њ –≤–Є—А–Њ–±–љ–Є—Ж—В–≤–∞

–Ъ–ї—О—З–Њ–≤—Ц —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–Є —В–∞ –њ–Њ–Ї—А–∞—Й–µ–љ–љ—П

SpaCy 4.0 –њ—А–Њ–њ–Њ–љ—Г—Ф –Ј–љ–∞—З–љ—Ц –њ–Њ–Ї—А–∞—Й–µ–љ–љ—П:

–Ж–љ—В–µ–≥—А–∞—Ж—Ц—П —В—А–∞–љ—Б—Д–Њ—А–Љ–∞—В–Њ—А—Ц–≤: –Ю–љ–Њ–≤–ї–µ–љ—Ц –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В–Є –Ї–Њ–љ–≤–µ—Ф—А–∞ —В—А–∞–љ—Б—Д–Њ—А–Љ–∞—В–Њ—А—Ц–≤ —В–µ–њ–µ—А –њ—А–∞—Ж—О—О—В—М –±–µ–Ј–њ–Њ—Б–µ—А–µ–і–љ—М–Њ –Ј –љ–∞–є–љ–Њ–≤—Ц—И–Є–Љ–Є –Љ–Њ–і–µ–ї—П–Љ–Є, –Ј–±–µ—А—Ц–≥–∞—О—З–Є –њ—А–Є —Ж—М–Њ–Љ—Г –µ—Д–µ–Ї—В–Є–≤–љ—Г –∞—А—Е—Ц—В–µ–Ї—В—Г—А—Г –Њ–±—А–Њ–±–Ї–Є SpaCy.

–Я–Њ–Ї—А–∞—Й–µ–љ–∞ –±–∞–≥–∞—В–Њ–њ—А–Њ—Ж–µ—Б–Њ—А–љ—Ц—Б—В—М: –Э–Њ–≤—Ц –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц –њ–∞—А–∞–ї–µ–ї—М–љ–Њ—Ч –Њ–±—А–Њ–±–Ї–Є –Ј–∞–±–µ–Ј–њ–µ—З—Г—О—В—М –Љ–∞–є–ґ–µ –ї—Ц–љ—Ц–є–љ–µ –Љ–∞—Б—И—В–∞–±—Г–≤–∞–љ–љ—П –і–ї—П –Ј–∞–≤–і–∞–љ—М –Њ–±—А–Њ–±–Ї–Є –і–Њ–Ї—Г–Љ–µ–љ—В—Ц–≤, —Й–Њ —А–Њ–±–Є—В—М SpaCy –њ—А–Є–і–∞—В–љ–Є–Љ –і–ї—П –њ–∞–Ї–µ—В–љ–Њ—Ч –Њ–±—А–Њ–±–Ї–Є –≤–µ–ї–Є—З–µ–Ј–љ–Є—Е —В–µ–Ї—Б—В–Њ–≤–Є—Е –Ї–Њ–ї–µ–Ї—Ж—Ц–є.

–†–Њ–Ј—И–Є—А–µ–љ–µ —Б—В—А—Г–Ї—В—Г—А–Њ–≤–∞–љ–µ –њ—А–Њ–≥–љ–Њ–Ј—Г–≤–∞–љ–љ—П: –Ю–Ї—А—Ц–Љ —А–Њ–Ј–њ—Ц–Ј–љ–∞–≤–∞–љ–љ—П —Ц–Љ–µ–љ–Њ–≤–∞–љ–Є—Е —Б—Г—В–љ–Њ—Б—В–µ–є —В–∞ –њ–∞—А—Б–Є–љ–≥—Г –Ј–∞–ї–µ–ґ–љ–Њ—Б—В–µ–є, SpaCy —В–µ–њ–µ—А –њ—А–Њ–њ–Њ–љ—Г—Ф —А–Њ–Ј—И–Є—А–µ–љ—Г –њ—Ц–і—В—А–Є–Љ–Ї—Г –і–ї—П –Ї–Њ—А–Є—Б—В—Г–≤–∞—Ж—М–Ї–Є—Е –Ј–∞–≤–і–∞–љ—М —Б—В—А—Г–Ї—В—Г—А–Њ–≤–∞–љ–Њ–≥–Њ –њ—А–Њ–≥–љ–Њ–Ј—Г–≤–∞–љ–љ—П –Ј–∞–≤–і—П–Ї–Є –±—Ц–ї—М—И –≥–љ—Г—З–Ї—Ц–є —Б—В—А—Г–Ї—В—Г—А—Ц –∞–љ–Њ—В–∞—Ж—Ц–є —В–∞ –љ–∞–≤—З–∞–љ–љ—П.

–Ь–µ–љ—И—Ц –≤–Є–Љ–Њ–≥–Є –і–Њ —Б–µ—А–µ–і–Њ–≤–Є—Й–∞ –≤–Є–Ї–Њ–љ–∞–љ–љ—П: –Э–µ–Ј–≤–∞–ґ–∞—О—З–Є –љ–∞ —А–Њ–Ј—И–Є—А–µ–љ—Ц –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц, –Њ—Б–љ–Њ–≤–љ—Ц –Ї–Њ–љ–≤–µ—Ф—А–Є –Њ–±—А–Њ–±–Ї–Є —В–µ–њ–µ—А –Љ–Њ–ґ—Г—В—М –њ—А–∞—Ж—О–≤–∞—В–Є –Ј—Ц –Ј–љ–∞—З–љ–Њ –Љ–µ–љ—И–Є–Љ —Б–њ–Њ–ґ–Є–≤–∞–љ–љ—П–Љ –њ–∞–Љ'—П—В—Ц, —Й–Њ —Ф –Ї—А–Є—В–Є—З–љ–Њ –≤–∞–ґ–ї–Є–≤–Є–Љ –і–ї—П —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П –≤ —Б–µ—А–µ–і–Њ–≤–Є—Й–∞—Е –Ј –Њ–±–Љ–µ–ґ–µ–љ–Є–Љ–Є —А–µ—Б—Г—А—Б–∞–Љ–Є.

–Я–Њ–Ї—А–∞—Й–µ–љ–Є–є –Љ–µ—Е–∞–љ—Ц–Ј–Љ –њ—А–∞–≤–Є–ї: –°–Є—Б—В–µ–Љ–∞ –Ј—Ц—Б—В–∞–≤–ї–µ–љ–љ—П –Ј—Ц –Ј—А–∞–Ј–Ї–∞–Љ–Є –±—Г–ї–∞ –њ–Њ–≤–љ—Ц—Б—В—О –њ–µ—А–µ—А–Њ–±–ї–µ–љ–∞, –њ—А–Њ–њ–Њ–љ—Г—О—З–Є –њ–Њ—В—Г–ґ–љ—Ц—И—Ц –≤–Є—А–∞–Ј–Є —В–∞ –њ–Њ–Ї—А–∞—Й—Г—О—З–Є —И–≤–Є–і–Ї—Ц—Б—В—М –Ј—Ц—Б—В–∞–≤–ї–µ–љ–љ—П –і–Њ 300%.

–І–Њ–Љ—Г —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –Њ–±–Є—А–∞—О—В—М –є–Њ–≥–Њ

SpaCy –њ—А–Њ–і–Њ–≤–ґ—Г—Ф –Ј–∞–ї–Є—И–∞—В–Є—Б—П –Ї—А–∞—Й–Є–Љ –≤–Є–±–Њ—А–Њ–Љ –і–ї—П –≤–Є—А–Њ–±–љ–Є—З–Є—Е —Б–Є—Б—В–µ–Љ, –Њ—Б–Ї—Ц–ї—М–Ї–Є –≤—Ц–љ –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф –њ—А–Њ–Љ–Є—Б–ї–Њ–≤—Г –њ—А–Њ–і—Г–Ї—В–Є–≤–љ—Ц—Б—В—М –Ј—Ц –Ј—А—Г—З–љ–Є–Љ –і–ї—П —А–Њ–Ј—А–Њ–±–љ–Є–Ї—Ц–≤ API. –Я—А–Њ–і—Г–Љ–∞–љ–∞ –Њ–±'—Ф–Ї—В–љ–Њ-–Њ—А—Ц—Ф–љ—В–Њ–≤–∞–љ–∞ –∞—А—Е—Ц—В–µ–Ї—В—Г—А–∞ –і–Њ–Ј–≤–Њ–ї—П—Ф –ї–µ–≥–Ї–Њ —Ц–љ—В–µ–≥—А—Г–≤–∞—В–Є –є–Њ–≥–Њ —Г –≤–µ–ї–Є–Ї—Ц –њ—А–Њ–≥—А–∞–Љ–Є, –Ј–±–µ—А—Ц–≥–∞—О—З–Є –њ—А–Є —Ж—М–Њ–Љ—Г —Б—В–∞–±—Ц–ї—М–љ—Г –њ—А–Њ–і—Г–Ї—В–Є–≤–љ—Ц—Б—В—М.

–Э–Њ–≤–Є–є —Д—А–µ–є–Љ–≤–Њ—А–Ї ¬ЂSpaCy Projects¬ї —В–∞–Ї–Њ–ґ —Б–њ—А–Њ—Б—В–Є–≤ —Г–њ–∞–Ї–Њ–≤–Ї—Г —В–∞ —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П –Ї–Њ–Љ–њ–ї–µ–Ї—Б–љ–Є—Е NLP-–Ї–Њ–љ–≤–µ—Ф—А—Ц–≤, –і–Њ–Ј–≤–Њ–ї—П—О—З–Є –Ї–Њ–Љ–∞–љ–і–∞–Љ —Б—В–∞–љ–і–∞—А—В–Є–Ј—Г–≤–∞—В–Є —Б–≤–Њ—Ч —А–Њ–±–Њ—З—Ц –њ—А–Њ—Ж–µ—Б–Є —А–Њ–Ј—А–Њ–±–Ї–Є –≤—Ц–і –µ–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В—Ц–≤ –і–Њ –≤–Є—А–Њ–±–љ–Є—Ж—В–≤–∞.

–Ж–і–µ–∞–ї—М–љ—Ц –≤–∞—А—Ц–∞–љ—В–Є –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П

SpaCy 4.0 —Ц–і–µ–∞–ї—М–љ–Њ –њ—Ц–і—Е–Њ–і–Є—В—М –і–ї—П:

–Т–Є—Б–Њ–Ї–Њ–њ—А–Њ–і—Г–Ї—В–Є–≤–љ–Є—Е —Б–Є—Б—В–µ–Љ –Њ–±—А–Њ–±–Ї–Є —В–µ–Ї—Б—В—Г

–Т–Є—А–Њ–±–љ–Є—З–Є—Е —Б–µ—А–µ–і–Њ–≤–Є—Й, –і–µ –љ–∞–і—Ц–є–љ—Ц—Б—В—М —В–∞ –њ–µ—А–µ–і–±–∞—З—Г–≤–∞–љ—Ц—Б—В—М –Љ–∞—О—В—М –≤–Є—А—Ц—И–∞–ї—М–љ–µ –Ј–љ–∞—З–µ–љ–љ—П

–Ч–∞—Б—В–Њ—Б—Г–љ–Ї—Ц–≤, —Й–Њ –њ–Њ—В—А–µ–±—Г—О—В—М —А–Њ–Ј–њ—Ц–Ј–љ–∞–≤–∞–љ–љ—П —Ц–Љ–µ–љ–Њ–≤–∞–љ–Є—Е —Б—Г—В–љ–Њ—Б—В–µ–є —В–∞ –≤–Є–ї—Г—З–µ–љ–љ—П –Ј–≤'—П–Ј–Ї—Ц–≤ –њ—А–Њ–Љ–Є—Б–ї–Њ–≤–Њ–≥–Њ —А—Ц–≤–љ—П

–Я—А–Њ–µ–Ї—В—Ц–≤ –Ј –Њ–±–Љ–µ–ґ–µ–љ–љ—П–Љ–Є —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П (–њ–∞–Љ'—П—В—М, –Њ–±—З–Є—Б–ї—О–≤–∞–ї—М–љ–∞ –њ–Њ—В—Г–ґ–љ—Ц—Б—В—М)

–Ъ–Њ–Љ–∞–љ–і, —П–Ї–Є–Љ –њ–Њ—В—А—Ц–±–љ—Ц —П–Ї –Ї–ї–∞—Б–Є—З–љ—Ц –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц NLP, —В–∞–Ї —Ц —Б—Г—З–∞—Б–љ—Ц –љ–µ–є—А–Њ–љ–љ—Ц –њ—Ц–і—Е–Њ–і–Є

–Ь—Ц—А–Ї—Г–≤–∞–љ–љ—П

–•–Њ—З–∞ SpaCy –і–Њ—Б—П–≥–ї–∞ –Ј–љ–∞—З–љ–Є—Е —Г—Б–њ—Ц—Е—Ц–≤ —Г –≤–њ—А–Њ–≤–∞–і–ґ–µ–љ–љ—Ц –Љ–Њ–і–µ–ї–µ–є —В—А–∞–љ—Б—Д–Њ—А–Љ–∞—В–Њ—А—Ц–≤, –≤–Њ–љ–∞ –≤—Б–µ —Й–µ –љ–µ –њ—А–Њ–њ–Њ–љ—Г—Ф —В–∞–Ї–Њ–≥–Њ –ґ —И–Є—А–Њ–Ї–Њ–≥–Њ —Б–њ–µ–Ї—В—А—Г –њ–µ—А–µ–і–Њ–≤–Є—Е –і–Њ—Б–ї—Ц–і–љ–Є—Ж—М–Ї–Є—Е —А–µ–∞–ї—Ц–Ј–∞—Ж—Ц–є, —П–Ї Hugging Face. –Ъ—А—Ц–Љ —В–Њ–≥–Њ, –і–µ—П–Ї—Ц —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –≤–≤–∞–ґ–∞—О—В—М –є–Њ–≥–Њ –љ–µ—З—Ц—В–Ї—Г –∞—А—Е—Ц—В–µ–Ї—В—Г—А—Г –Љ–µ–љ—И –≥–љ—Г—З–Ї–Њ—О –і–ї—П –≤–Є—Б–Њ–Ї–Њ –љ–∞–ї–∞—И—В–Њ–≤–∞–љ–Є—Е –і–Њ—Б–ї—Ц–і–љ–Є—Ж—М–Ї–Є—Е –Ј–∞—Б—В–Њ—Б—Г–≤–∞–љ—М.

3. Cohere SDK: API-—Ц–љ—В–µ–ї–µ–Ї—В—Г–∞–ї—М–љ–Є–є –∞–љ–∞–ї—Ц–Ј –њ–µ—А—И–Њ—Ч –Љ–Њ–≤–Є

–Ъ–ї—О—З–Њ–≤—Ц —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–Є —В–∞ –њ–Њ–Ї—А–∞—Й–µ–љ–љ—П

–Я–ї–∞—В—Д–Њ—А–Љ–∞ Cohere –њ—А–Њ–њ–Њ–љ—Г—Ф –Ї—Ц–ї—М–Ї–∞ –њ–µ—А–µ–Ї–Њ–љ–ї–Є–≤–Є—Е –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В–µ–є:

–Ь–Њ–і–µ–ї—Ц Command —В–∞ Command-R: –¶—Ц –Љ–Њ–і–µ–ї—Ц —З—Г–і–Њ–≤–Њ –≤–Є–Ї–Њ–љ—Г—О—В—М –Ї–Њ–љ–Ї—А–µ—В–љ—Ц —Ц–љ—Б—В—А—Г–Ї—Ж—Ц—Ч —В–∞ —А–Њ–Ј—Г–Љ—Ц—О—В—М –љ—О–∞–љ—Б–Њ–≤–∞–љ—Ц –Ј–∞–њ–Є—В–Є, —Й–Њ —А–Њ–±–Є—В—М —Ч—Е —Ц–і–µ–∞–ї—М–љ–Є–Љ–Є –і–ї—П —Б—В–≤–Њ—А–µ–љ–љ—П —Ц–љ—Б—В—А—Г–Љ–µ–љ—В—Ц–≤, —П–Ї—Ц —В–Њ—З–љ–Њ —А–µ–∞–≥—Г—О—В—М –љ–∞ –Ј–∞–њ–Є—В–Є –Ї–Њ—А–Є—Б—В—Г–≤–∞—З—Ц–≤.

–Ь–Њ–і–µ–ї—Ц –≤–±—Г–і–Њ–≤—Г–≤–∞–љ–љ—П: –Ь–Њ–і–µ–ї—Ц –≤–±—Г–і–Њ–≤—Г–≤–∞–љ–љ—П –Њ—Б—В–∞–љ–љ—М–Њ–≥–Њ –њ–Њ–Ї–Њ–ї—Ц–љ–љ—П —Б—В–≤–Њ—А—О—О—В—М –љ–∞–і–Ј–≤–Є—З–∞–є–љ–Њ —В–Њ—З–љ—Ц —Б–µ–Љ–∞–љ—В–Є—З–љ—Ц –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–љ—П, –Ј–љ–∞—З–љ–Њ –њ–µ—А–µ–≤–µ—А—И—Г—О—З–Є –њ–Њ–њ–µ—А–µ–і–љ—Ц –њ—Ц–і—Е–Њ–і–Є –і–Њ –Ј–∞–≤–і–∞–љ—М –њ–Њ—И—Г–Ї—Г —В–∞ –Ї–ї–∞—Б–Є—Д—Ц–Ї–∞—Ж—Ц—Ч.

–Э–∞–ї–∞—И—В—Г–≤–∞–љ–љ—П –і–ї—П –њ—Ц–і–њ—А–Є—Ф–Љ—Б—В–≤–∞: –Ф–ї—П –Њ—А–≥–∞–љ—Ц–Ј–∞—Ж—Ц–є –Ј –Њ—Б–Њ–±–ї–Є–≤–Є–Љ–Є –њ–Њ—В—А–µ–±–∞–Љ–Є Cohere —В–µ–њ–µ—А –њ—А–Њ–њ–Њ–љ—Г—Ф –≤–∞—А—Ц–∞–љ—В–Є –љ–∞–ї–∞—И—В—Г–≤–∞–љ–љ—П, —П–Ї—Ц –∞–і–∞–њ—В—Г—О—В—М —Ч—Е–љ—Ц –Њ—Б–љ–Њ–≤–љ—Ц –Љ–Њ–і–µ–ї—Ц –і–Њ —Б–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ–Є—Е –Њ–±–ї–∞—Б—В–µ–є –±–µ–Ј –љ–µ–Њ–±—Е—Ц–і–љ–Њ—Б—В—Ц –Љ–∞—Б–Є–≤–љ–Є—Е –љ–∞–±–Њ—А—Ц–≤ –і–∞–љ–Є—Е –і–ї—П –љ–∞–≤—З–∞–љ–љ—П.

–С–∞–≥–∞—В–Њ–Љ–Њ–≤–љ–∞ –њ—Ц–і—В—А–Є–Љ–Ї–∞: –Э–∞–і—Ц–є–љ—Ц –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц –і–ї—П –њ–Њ–љ–∞–і 100 –Љ–Њ–≤ –і–Њ–Ј–≤–Њ–ї—П—О—В—М —Б—В–≤–Њ—А—О–≤–∞—В–Є –≥–ї–Њ–±–∞–ї—М–љ—Ц –њ—А–Њ–≥—А–∞–Љ–Є –±–µ–Ј –љ–µ–Њ–±—Е—Ц–і–љ–Њ—Б—В—Ц –Њ–Ї—А–µ–Љ–Є—Е –Љ–Њ–і–µ–ї–µ–є –і–ї—П –Ї–Њ–ґ–љ–Њ—Ч –Љ–Њ–≤–Є.

–Т—Ц–і–њ–Њ–≤—Ц–і–∞–ї—М–љ—Ц –Ј–∞—Б–Њ–±–Є –Ї–Њ–љ—В—А–Њ–ї—О –®–Ж: –Т–±—Г–і–Њ–≤–∞–љ—Ц —Д—Ц–ї—М—В—А–Є –±–µ–Ј–њ–µ–Ї–Є —В–∞ –≤–Є—П–≤–ї–µ–љ–љ—П —Г–њ–µ—А–µ–і–ґ–µ–љ–Њ—Б—В—Ц –і–Њ–њ–Њ–Љ–∞–≥–∞—О—В—М —А–Њ–Ј—А–Њ–±–љ–Є–Ї–∞–Љ —Б—В–≤–Њ—А—О–≤–∞—В–Є —Б–Є—Б—В–µ–Љ–Є, —Й–Њ –≤—Ц–і–њ–Њ–≤—Ц–і–∞—О—В—М –і–µ–і–∞–ї—Ц –≤–∞–ґ–ї–Є–≤—Ц—И–Є–Љ –µ—В–Є—З–љ–Є–Љ —Б—В–∞–љ–і–∞—А—В–∞–Љ.

–І–Њ–Љ—Г —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –Њ–±–Є—А–∞—О—В—М –є–Њ–≥–Њ

Cohere SDK –Ј–і–Њ–±—Г–≤ –њ–Њ–њ—Г–ї—П—А–љ—Ц—Б—В—М –≥–Њ–ї–Њ–≤–љ–Є–Љ —З–Є–љ–Њ–Љ —В–Њ–Љ—Г, —Й–Њ –≤—Ц–љ –Ј–љ–∞—З–љ–Њ –Ј–љ–Є–ґ—Г—Ф –±–∞—А'—Ф—А –і–ї—П –≤–њ—А–Њ–≤–∞–і–ґ–µ–љ–љ—П —Б–Ї–ї–∞–і–љ–Є—Е –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В–µ–є NLP. –†–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –±–µ–Ј –і–Њ—Б–≤—Ц–і—Г –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –љ–∞–≤—З–∞–љ–љ—П –Љ–Њ–ґ—Г—В—М –і–Њ–і–∞–≤–∞—В–Є —А–Њ–Ј—И–Є—А–µ–љ–µ —А–Њ–Ј—Г–Љ—Ц–љ–љ—П –Љ–Њ–≤–Є –і–Њ –њ—А–Њ–≥—А–∞–Љ –Ј –Љ—Ц–љ—Ц–Љ–∞–ї—М–љ–Є–Љ –Ї–Њ–і–Њ–Љ, –Ј–±–µ—А—Ц–≥–∞—О—З–Є –њ—А–Є —Ж—М–Њ–Љ—Г –і–µ—В–∞–ї—М–љ–Є–є –Ї–Њ–љ—В—А–Њ–ї—М –љ–∞–і –њ–Њ–≤–µ–і—Ц–љ–Ї–Њ—О –Љ–Њ–і–µ–ї—Ц, –Ї–Њ–ї–Є —Ж–µ –љ–µ–Њ–±—Е—Ц–і–љ–Њ.

–Я—Ц–і—Е—Ц–і, –Њ—А—Ц—Ф–љ—В–Њ–≤–∞–љ–Є–є –љ–∞ API, —В–∞–Ї–Њ–ґ –Њ–Ј–љ–∞—З–∞—Ф, —Й–Њ –Ї–Њ–Љ–∞–љ–і–∞–Љ –љ–µ –њ–Њ—В—А—Ц–±–љ–Њ —В—Г—А–±—Г–≤–∞—В–Є—Б—П –њ—А–Њ —Г–њ—А–∞–≤–ї—Ц–љ–љ—П —Ц–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А–Њ—О –∞–±–Њ –≤—Ц–і—Б—В–µ–ґ–µ–љ–љ—П –Њ—Б—В–∞–љ–љ—Ц—Е –і–Њ—Б—П–≥–љ–µ–љ—М –і–Њ—Б–ї—Ц–і–ґ–µ–љ—М вАФ Cohere –Ј–∞–є–Љ–∞—Ф—В—М—Б—П —Ж–Є–Љ–Є –∞—Б–њ–µ–Ї—В–∞–Љ–Є, –і–Њ–Ј–≤–Њ–ї—П—О—З–Є —А–Њ–Ј—А–Њ–±–љ–Є–Ї–∞–Љ –Ј–Њ—Б–µ—А–µ–і–Є—В–Є—Б—П –љ–∞ –ї–Њ–≥—Ц—Ж—Ц —Б–≤–Њ—Ч—Е –њ—А–Њ–≥—А–∞–Љ.

–Ж–і–µ–∞–ї—М–љ—Ц –≤–∞—А—Ц–∞–љ—В–Є –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П

Cohere SDK —З—Г–і–Њ–≤–Њ –њ—Ц–і—Е–Њ–і–Є—В—М –і–ї—П:

–°—В–∞—А—В–∞–њ—Ц–≤ —В–∞ –Ї–Њ–Љ–∞–љ–і –±–µ–Ј –≤–Є–і—Ц–ї–µ–љ–Њ—Ч —Ц–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А–Є –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –љ–∞–≤—З–∞–љ–љ—П

–Я—А–Њ–≥—А–∞–Љ, —П–Ї—Ц –њ–Њ—В—А–µ–±—Г—О—В—М —И–≤–Є–і–Ї–Њ–≥–Њ –Љ–∞—Б—И—В–∞–±—Г–≤–∞–љ–љ—П –±–µ–Ј —Г–њ—А–∞–≤–ї—Ц–љ–љ—П —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П–Љ –Љ–Њ–і–µ–ї–µ–є

–Я—А–Њ–µ–Ї—В—Ц–≤, —Й–Њ –њ–Њ—В—А–µ–±—Г—О—В—М –љ–∞–і—Ц–є–љ–Њ—Б—В—Ц —В–∞ –њ—Ц–і—В—А–Є–Љ–Ї–Є –Ї–Њ—А–њ–Њ—А–∞—В–Є–≤–љ–Њ–≥–Њ —А—Ц–≤–љ—П

–С–∞–≥–∞—В–Њ–Љ–Њ–≤–љ–Є—Е –њ—А–Њ–≥—А–∞–Љ, —Й–Њ –Њ–±—Б–ї—Г–≥–Њ–≤—Г—О—В—М —Б–≤—Ц—В–Њ–≤—Ц —А–Є–љ–Ї–Є

–Т–Є–њ–∞–і–Ї—Ц–≤ –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П, –і–µ –≤—Ц–і–њ–Њ–≤—Ц–і–∞–ї—М–љ–∞ –њ—А–∞–Ї—В–Є–Ї–∞ —И—В—Г—З–љ–Њ–≥–Њ —Ц–љ—В–µ–ї–µ–Ї—В—Г —Ф –њ—А—Ц–Њ—А–Є—В–µ—В–Њ–Љ

–Ь—Ц—А–Ї—Г–≤–∞–љ–љ—П

–Ю—Б–љ–Њ–≤–љ–Є–Љ –Ї–Њ–Љ–њ—А–Њ–Љ—Ц—Б–Њ–Љ Cohere —Ф —В–µ, —Й–Њ —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –њ–Њ–Ї–ї–∞–і–∞—О—В—М—Б—П –љ–∞ —Б—В–Њ—А–Њ–љ–љ—Ц–є —Б–µ—А–≤—Ц—Б, –∞ –љ–µ –Ј–∞–њ—Г—Б–Ї–∞—О—В—М –Љ–Њ–і–µ–ї—Ц —Г –≤–ї–∞—Б–љ—Ц–є —Ц–љ—Д—А–∞—Б—В—А—Г–Ї—В—Г—А—Ц. –¶–µ —Б—В–≤–Њ—А—О—Ф –њ–Њ—В–µ–љ—Ж—Ц–є–љ—Ц –њ—А–Њ–±–ї–µ–Љ–Є —Й–Њ–і–Њ –Ї–Њ–љ—Д—Ц–і–µ–љ—Ж—Ц–є–љ–Њ—Б—В—Ц –і–∞–љ–Є—Е, –і–Њ—Б—В—Г–њ–љ–Њ—Б—В—Ц –њ–Њ—Б–ї—Г–≥ —В–∞ –і–Њ–≤–≥–Њ—Б—В—А–Њ–Ї–Њ–≤–Њ—Ч —Б—В–∞–±—Ц–ї—М–љ–Њ—Б—В—Ц —Ж—Ц–љ. –Ф–µ—П–Ї—Ц —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є —В–∞–Ї–Њ–ґ –Ј–∞–Ј–љ–∞—З–∞—О—В—М, —Й–Њ –њ—Ц–і—Е—Ц–і –љ–∞ –Њ—Б–љ–Њ–≤—Ц API, —Е–Њ—З–∞ –є –Ј—А—Г—З–љ–Є–є, —Ц–љ–Њ–і—Ц –Њ–±–Љ–µ–ґ—Г—Ф –≥–љ—Г—З–Ї—Ц—Б—В—М –њ–Њ—А—Ц–≤–љ—П–љ–Њ –Ј –њ—А—П–Љ–Є–Љ –і–Њ—Б—В—Г–њ–Њ–Љ –і–Њ –≤–љ—Г—В—А—Ц—И–љ—Ц—Е —Д—Г–љ–Ї—Ж—Ц–є –Љ–Њ–і–µ–ї—Ц.

4. PyTorch NLP (torchtext 3.0): –Т–Є–±—Ц—А –і–Њ—Б–ї—Ц–і–љ–Є–Ї–∞

–Ъ–ї—О—З–Њ–≤—Ц —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–Є —В–∞ –њ–Њ–Ї—А–∞—Й–µ–љ–љ—П

–Ю—Б—В–∞–љ–љ—П –≤–µ—А—Б—Ц—П –Љ—Ц—Б—В–Є—В—М –Ї—Ц–ї—М–Ї–∞ –Ј–љ–∞—З–љ–Є—Е –Њ–љ–Њ–≤–ї–µ–љ—М:

–Т–±—Г–і–Њ–≤–∞–љ–∞ –њ—Ц–і—В—А–Є–Љ–Ї–∞ –∞—А—Е—Ц—В–µ–Ї—В—Г—А Transformer: –Я–µ—А—И–Њ–Ї–ї–∞—Б–љ–∞ —А–µ–∞–ї—Ц–Ј–∞—Ж—Ц—П –Љ–µ—Е–∞–љ—Ц–Ј–Љ—Ц–≤ —Г–≤–∞–≥–Є —В–∞ –±–ї–Њ–Ї—Ц–≤ transformer —Б–њ—А–Њ—Й—Г—Ф –≤–њ—А–Њ–≤–∞–і–ґ–µ–љ–љ—П –Ї–Њ—А–Є—Б—В—Г–≤–∞—Ж—М–Ї–Є—Е –∞—А—Е—Ц—В–µ–Ї—В—Г—А.

–Ю–њ—В–Є–Љ—Ц–Ј–Њ–≤–∞–љ—Ц –Ї–Њ–љ–≤–µ—Ф—А–Є –Њ–±—А–Њ–±–Ї–Є –і–∞–љ–Є—Е: –Э–Њ–≤—Ц –Њ–њ–µ—А–∞—Ж—Ц—Ч –Њ–±—А–Њ–±–Ї–Є –≤–µ–Ї—В–Њ—А–Є–Ј–Њ–≤–∞–љ–Њ–≥–Њ —В–µ–Ї—Б—В—Г –µ—Д–µ–Ї—В–Є–≤–љ—Ц—И–µ –≤–Є–Ї–Њ—А–Є—Б—В–Њ–≤—Г—О—В—М —Б—Г—З–∞—Б–љ—Ц –њ—А–Њ—Ж–µ—Б–Њ—А–Є —В–∞ –≥—А–∞—Д—Ц—З–љ—Ц –њ—А–Њ—Ж–µ—Б–Њ—А–Є, –Ј–љ–∞—З–љ–Њ –њ—А–Є—И–≤–Є–і—И—Г—О—З–Є –µ—В–∞–њ–Є –њ–Њ–њ–µ—А–µ–і–љ—М–Њ—Ч –Њ–±—А–Њ–±–Ї–Є.

–Я–Њ–Ї—А–∞—Й–µ–љ–∞ –њ–ї–∞—В—Д–Њ—А–Љ–∞ –љ–∞–≤—З–∞–љ–љ—П –Ј –њ–µ—А–µ–љ–µ—Б–µ–љ–љ—П–Љ: –£–і–Њ—Б–Ї–Њ–љ–∞–ї–µ–љ–Є–є API —Б–њ—А–Њ—Й—Г—Ф –∞–і–∞–њ—В–∞—Ж—Ц—О –њ–Њ–њ–µ—А–µ–і–љ—М–Њ –љ–∞–≤—З–µ–љ–Є—Е –Љ–Њ–і–µ–ї–µ–є –і–Њ –љ–Њ–≤–Є—Е –Ј–∞–≤–і–∞–љ—М, –Ј–±–µ—А—Ц–≥–∞—О—З–Є –њ—А–Є —Ж—М–Њ–Љ—Г —В–Њ—З–љ–Є–є –Ї–Њ–љ—В—А–Њ–ї—М –љ–∞–і –њ—А–Њ—Ж–µ—Б–Њ–Љ –љ–∞–≤—З–∞–љ–љ—П.

–Ж–љ—Б—В—А—Г–Љ–µ–љ—В–Є –Ї–≤–∞–љ—В—Г–≤–∞–љ–љ—П —В–∞ –Њ–±—А—Ц–Ј–∞–љ–љ—П: –Т–±—Г–і–Њ–≤–∞–љ—Ц –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц —Б—В–Є—Б–љ–µ–љ–љ—П –Љ–Њ–і–µ–ї—Ц –і–Њ–Ј–≤–Њ–ї—П—О—В—М –і–Њ—Б–ї—Ц–і–љ–Є–Ї–∞–Љ –Ј–Љ–µ–љ—И–Є—В–Є —А–Њ–Ј–Љ—Ц—А –Љ–Њ–і–µ–ї—Ц —В–∞ —З–∞—Б –≤–Є–≤–µ–і–µ–љ–љ—П –±–µ–Ј –љ–∞–і–Љ—Ц—А–љ–Њ–≥–Њ –Ј–љ–Є–ґ–µ–љ–љ—П –њ—А–Њ–і—Г–Ї—В–Є–≤–љ–Њ—Б—В—Ц.

–Я–Њ–Ї—А–∞—Й–µ–љ–∞ –њ–∞–Ї–µ—В–љ–∞ –Њ–±—А–Њ–±–Ї–∞: –†–Њ–Ј—Г–Љ–љ—Ц—И—Ц —Б—В—А–∞—В–µ–≥—Ц—Ч –њ–∞–Ї–µ—В–љ–Њ—Ч –Њ–±—А–Њ–±–Ї–Є –і–ї—П –њ–Њ—Б–ї—Ц–і–Њ–≤–љ–Њ—Б—В–µ–є –Ј–Љ—Ц–љ–љ–Њ—Ч –і–Њ–≤–ґ–Є–љ–Є –њ—А–Є–Ј–≤–Њ–і—П—В—М –і–Њ –µ—Д–µ–Ї—В–Є–≤–љ—Ц—И–Њ–≥–Њ –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П –≥—А–∞—Д—Ц—З–љ–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б–Њ—А–∞ –њ—Ц–і —З–∞—Б –љ–∞–≤—З–∞–љ–љ—П.

–І–Њ–Љ—Г –і–Њ—Б–ї—Ц–і–љ–Є–Ї–Є —В–∞ —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –Њ–±–Є—А–∞—О—В—М –є–Њ–≥–Њ

PyTorch NLP –Ј–∞–ї–Є—И–∞—Ф—В—М—Б—П –Ї—А–∞—Й–Є–Љ –≤–Є–±–Њ—А–Њ–Љ –і–ї—П –і–Њ—Б–ї—Ц–і–љ–Є—Ж—М–Ї–Є—Е —В–∞ —Б–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ–Є—Е –Ј–∞—Б—В–Њ—Б—Г–≤–∞–љ—М, –Њ—Б–Ї—Ц–ї—М–Ї–Є –≤—Ц–љ –њ—А–Њ–њ–Њ–љ—Г—Ф –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Г –≥–љ—Г—З–Ї—Ц—Б—В—М –±–µ–Ј —И–Ї–Њ–і–Є –і–ї—П –Ј—А—Г—З–љ–Њ—Б—В—Ц –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П. –Ж–Љ–њ–µ—А–∞—В–Є–≤–љ–Є–є —Б—В–Є–ї—М –њ—А–Њ–≥—А–∞–Љ—Г–≤–∞–љ–љ—П –≤—Ц–і–њ–Њ–≤—Ц–і–∞—Ф —Б–њ–Њ—Б–Њ–±—Г –Љ–Є—Б–ї–µ–љ–љ—П –±—Ц–ї—М—И–Њ—Б—В—Ц —А–Њ–Ј—А–Њ–±–љ–Є–Ї—Ц–≤, —Й–Њ –њ–Њ–ї–µ–≥—И—Г—Ф –љ–∞–ї–∞–≥–Њ–і–ґ–µ–љ–љ—П –Љ–Њ–і–µ–ї–µ–є —В–∞ –µ–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В–Є –Ј –љ–Њ–≤–Є–Љ–Є –њ—Ц–і—Е–Њ–і–∞–Љ–Є.

–С–µ–Ј—И–Њ–≤–љ–∞ —Ц–љ—В–µ–≥—А–∞—Ж—Ц—П –Ј —И–Є—А—И–Њ—О –µ–Ї–Њ—Б–Є—Б—В–µ–Љ–Њ—О PyTorch —В–∞–Ї–Њ–ґ –Њ–Ј–љ–∞—З–∞—Ф, —Й–Њ –і–Њ—Б—П–≥–љ–µ–љ–љ—П –≤ –Ј–∞–≥–∞–ї—М–љ–Њ–Љ—Г –≥–ї–Є–±–Њ–Ї–Њ–Љ—Г –љ–∞–≤—З–∞–љ–љ—Ц (—В–∞–Ї—Ц —П–Ї –Љ–µ—В–Њ–і–Є –Њ–њ—В–Є–Љ—Ц–Ј–∞—Ж—Ц—Ч –∞–±–Њ –Љ–µ—В–Њ–і–Є –љ–∞–≤—З–∞–љ–љ—П) –љ–µ–≥–∞–є–љ–Њ –Ј–∞—Б—В–Њ—Б–Њ–≤–љ—Ц –і–Њ –Ј–∞–≤–і–∞–љ—М NLP.

–Ж–і–µ–∞–ї—М–љ—Ц –≤–∞—А—Ц–∞–љ—В–Є –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П

PyTorch NLP –љ–∞–є–Ї—А–∞—Й–µ –њ—Ц–і—Е–Њ–і–Є—В—М –і–ї—П:

–Ф–Њ—Б–ї—Ц–і–љ–Є—Ж—М–Ї–Є—Е –њ—А–Њ–µ–Ї—В—Ц–≤, —Й–Њ –і–Њ—Б–ї—Ц–і–ґ—Г—О—В—М –љ–Њ–≤—Ц –∞—А—Е—Ц—В–µ–Ї—В—Г—А–Є –∞–±–Њ –њ—Ц–і—Е–Њ–і–Є –і–Њ –љ–∞–≤—З–∞–љ–љ—П

–Я—А–Њ–≥—А–∞–Љ, —Й–Њ –њ–Њ—В—А–µ–±—Г—О—В—М –љ–∞–ї–∞—И—В–Њ–≤–∞–љ–Њ—Ч –њ–Њ–≤–µ–і—Ц–љ–Ї–Є –Љ–Њ–і–µ–ї—Ц, –љ–µ–і–Њ—Б—В—Г–њ–љ–Њ—Ч –≤ –±—Ц–±–ї—Ц–Њ—В–µ–Ї–∞—Е –≤–Є—Й–Њ–≥–Њ —А—Ц–≤–љ—П

–Ю—Б–≤—Ц—В–љ—Ц—Е –Ї–Њ–љ—В–µ–Ї—Б—В—Ц–≤, –і–µ –≤–∞–ґ–ї–Є–≤–µ —А–Њ–Ј—Г–Љ—Ц–љ–љ—П –≤–љ—Г—В—А—Ц—И–љ—Ц—Е –Љ–µ—Е–∞–љ—Ц–Ј–Љ—Ц–≤ –Љ–Њ–і–µ–ї—Ц

–Я—А–Њ–µ–Ї—В—Ц–≤, –і–µ –њ–Њ—В—А—Ц–±–љ–∞ —Ц–љ—В–µ–≥—А–∞—Ж—Ц—П –Ј –Ї–Њ–Љ–њ'—О—В–µ—А–љ–Є–Љ –Ј–Њ—А–Њ–Љ –∞–±–Њ —Ц–љ—И–Є–Љ–Є –Љ–Њ–і–∞–ї—Ц—В–∞—Ж—Ц—П–Љ–Є

–°–Є—В—Г–∞—Ж—Ц–є, —Й–Њ –≤–Є–Љ–∞–≥–∞—О—В—М –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–Њ–≥–Њ –Ї–Њ–љ—В—А–Њ–ї—О –љ–∞–і –њ—А–Њ—Ж–µ—Б–Њ–Љ –љ–∞–≤—З–∞–љ–љ—П

–Ь—Ц—А–Ї—Г–≤–∞–љ–љ—П

–У–љ—Г—З–Ї—Ц—Б—В—М PyTorch NLP –њ–Њ–≤'—П–Ј–∞–љ–∞ –Ј –Ї—А—Г—В—Ц—И–Њ—О –Ї—А–Є–≤–Њ—О –љ–∞–≤—З–∞–љ–љ—П —В–∞ –±—Ц–ї—М—И–Њ—О –≤—Ц–і–њ–Њ–≤—Ц–і–∞–ї—М–љ—Ц—Б—В—О –Ј–∞ –≤–њ—А–Њ–≤–∞–і–ґ–µ–љ–љ—П. –†–Њ–Ј—А–Њ–±–љ–Є–Ї–∞–Љ –њ–Њ—В—А—Ц–±–љ–Њ –њ—А–Є–є–Љ–∞—В–Є –±—Ц–ї—М—И–µ –∞—А—Е—Ц—В–µ–Ї—В—Г—А–љ–Є—Е —А—Ц—И–µ–љ—М —В–∞ –≤–њ—А–Њ–≤–∞–і–ґ—Г–≤–∞—В–Є –±—Ц–ї—М—И–µ –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В—Ц–≤ –Ј –љ—Г–ї—П –њ–Њ—А—Ц–≤–љ—П–љ–Њ –Ј –±—Ц–±–ї—Ц–Њ—В–µ–Ї–∞–Љ–Є –≤–Є—Й–Њ–≥–Њ —А—Ц–≤–љ—П. –Ъ—А—Ц–Љ —В–Њ–≥–Њ, –і–µ—П–Ї—Ц —Д—Г–љ–Ї—Ж—Ц—Ч –Њ–њ—В–Є–Љ—Ц–Ј–∞—Ж—Ц—Ч –≤–Є—А–Њ–±–љ–Є—Ж—В–≤–∞ –њ–Њ—В—А–µ–±—Г—О—В—М –і–Њ–і–∞—В–Ї–Њ–≤–Њ—Ч —А–Њ–±–Њ—В–Є –і–ї—П –љ–∞–ї–µ–ґ–љ–Њ–≥–Њ –≤–њ—А–Њ–≤–∞–і–ґ–µ–љ–љ—П.

–Я—А–Њ—В–µ—Б—В—Г–є—В–µ –Т–Р–® –С—Ц–Ј–љ–µ—Б –Ј–∞ –•–≤–Є–ї–Є–љ

–°—В–≤–Њ—А—Ц—В—М –Њ–±–ї—Ц–Ї–Њ–≤–Є–є –Ј–∞–њ–Є—Б —Ц –Ј–∞–њ—Г—Б—В—Ц—В—М —Б–≤–Њ–≥–Њ AI-—З–∞—В–±–Њ—В–∞ –Ј–∞ –ї—Ц—З–µ–љ—Ц —Е–≤–Є–ї–Є–љ–Є. –Я–Њ–≤–љ—Ц—Б—В—О –љ–∞–ї–∞—И—В–Њ–≤—Г—Ф—В—М—Б—П, –±–µ–Ј –љ–µ–Њ–±—Е—Ц–і–љ–Њ—Б—В—Ц –Ї–Њ–і—Г–≤–∞–љ–љ—П - –њ–Њ—З–љ—Ц—В—М –Ј–∞–ї—Г—З–∞—В–Є —Б–≤–Њ—Ч—Е –Ї–ї—Ц—Ф–љ—В—Ц–≤ –Љ–Є—В—В—Ф–≤–Њ!

5. JAX NLP (FLAX/Prax): –Ь–∞—Б—И—В–∞–±–љ–∞ –њ—А–Њ–і—Г–Ї—В–Є–≤–љ—Ц—Б—В—М

–Ъ–ї—О—З–Њ–≤—Ц —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–Є —В–∞ –њ–Њ–Ї—А–∞—Й–µ–љ–љ—П

–Х–Ї–Њ—Б–Є—Б—В–µ–Љ–∞ NLP JAX –њ—А–Њ–њ–Њ–љ—Г—Ф –Ї—Ц–ї—М–Ї–∞ –≤—Ц–і–Љ—Ц–љ–љ–Є—Е –њ–µ—А–µ–≤–∞–≥:

–Я—А–Њ–Ј–Њ—А–∞ –Ї–Њ–Љ–њ—Ц–ї—П—Ж—Ц—П XLA: –Р–≤—В–Њ–Љ–∞—В–Є—З–љ–∞ –Њ–њ—В–Є–Љ—Ц–Ј–∞—Ж—Ц—П –і–ї—П TPU, GPU —В–∞ —Б–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ–Њ–≥–Њ –Њ–±–ї–∞–і–љ–∞–љ–љ—П –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф –Ј–љ–∞—З–љ—Ц –њ–Њ–Ї—А–∞—Й–µ–љ–љ—П —И–≤–Є–і–Ї–Њ—Б—В—Ц –љ–∞–≤—З–∞–љ–љ—П —В–∞ –ї–Њ–≥—Ц—З–љ–Њ–≥–Њ –≤–Є—Б–љ–Њ–≤–Ї—Г.

–Ь–Њ–і–µ–ї—М —Д—Г–љ–Ї—Ж—Ц–Њ–љ–∞–ї—М–љ–Њ–≥–Њ –њ—А–Њ–≥—А–∞–Љ—Г–≤–∞–љ–љ—П: –І–Є—Б—В–Њ —Д—Г–љ–Ї—Ж—Ц–Њ–љ–∞–ї—М–љ–Є–є –њ—Ц–і—Е—Ц–і —Б–њ—А–Њ—Й—Г—Ф —А–Њ–Ј–њ–Њ–і—Ц–ї –љ–∞ –Ї—Ц–ї—М–Ї–Њ—Е –њ—А–Є—Б—В—А–Њ—П—Е —В–∞ –і–Њ–њ–Њ–Љ–∞–≥–∞—Ф —Г–љ–Є–Ї–љ—Г—В–Є –љ–µ–Ј–љ–∞—З–љ–Є—Е –њ–Њ–Љ–Є–ї–Њ–Ї –љ–∞–≤—З–∞–љ–љ—П.

–†–Њ–Ј—И–Є—А–µ–љ–Є–є –њ–∞—А–∞–ї–µ–ї—Ц–Ј–Љ: –Т–±—Г–і–Њ–≤–∞–љ–∞ –њ—Ц–і—В—А–Є–Љ–Ї–∞ –њ–∞—А–∞–ї–µ–ї—Ц–Ј–Љ—Г –Љ–Њ–і–µ–ї–µ–є, –і–∞–љ–Є—Е —В–∞ –Ї–Њ–љ–≤–µ—Ф—А—Ц–≤ —А–Њ–±–Є—В—М –љ–∞–≤—З–∞–љ–љ—П –Љ–∞—Б–Є–≤–љ–Є—Е –Љ–Њ–і–µ–ї–µ–є –і–Њ—Б—В—Г–њ–љ—Ц—И–Є–Љ.

–Ю–њ—В–Є–Љ—Ц–Ј–∞—Ж—Ц—П, —Б–њ–µ—Ж–Є—Д—Ц—З–љ–∞ –і–ї—П –Њ–±–ї–∞–і–љ–∞–љ–љ—П: –°–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ—Ц —А–µ–∞–ї—Ц–Ј–∞—Ж—Ц—Ч –њ–Њ–≤–љ–Њ—О –Љ—Ц—А–Њ—О –≤–Є–Ї–Њ—А–Є—Б—В–Њ–≤—Г—О—В—М –љ–∞–є–љ–Њ–≤—Ц—И—Ц —Д—Г–љ–Ї—Ж—Ц—Ч –њ—А–Є—Б–Ї–Њ—А—О–≤–∞—З–∞ –≤—Ц–і —А—Ц–Ј–љ–Є—Е –њ–Њ—Б—В–∞—З–∞–ї—М–љ–Є–Ї—Ц–≤ –Њ–±–ї–∞–і–љ–∞–љ–љ—П.

–Ж–љ—В–µ–≥—А–∞—Ж—Ц—П –і–Є—Д–µ—А–µ–љ—Ж—Ц–∞–ї—М–љ–Њ—Ч –Ї–Њ–љ—Д—Ц–і–µ–љ—Ж—Ц–є–љ–Њ—Б—В—Ц: –Т–±—Г–і–Њ–≤–∞–љ–∞ –њ—Ц–і—В—А–Є–Љ–Ї–∞ –њ—А–Є–≤–∞—В–љ–Є—Е –Љ–µ—В–Њ–і—Ц–≤ –љ–∞–≤—З–∞–љ–љ—П –≤—Ц–і–њ–Њ–≤—Ц–і–∞—Ф –Ј—А–Њ—Б—В–∞—О—З–Є–Љ –љ–Њ—А–Љ–∞—В–Є–≤–љ–Є–Љ –≤–Є–Љ–Њ–≥–∞–Љ —Й–Њ–і–Њ –Ї–Њ–љ—Д—Ц–і–µ–љ—Ж—Ц–є–љ–Њ—Б—В—Ц –і–∞–љ–Є—Е.

–І–Њ–Љ—Г –Ї–Њ–Љ–∞–љ–і–Є –Њ–±–Є—А–∞—О—В—М –є–Њ–≥–Њ

–Ю—А–≥–∞–љ—Ц–Ј–∞—Ж—Ц—Ч, —Й–Њ –њ—А–∞—Ж—О—О—В—М –Ј –љ–∞–і–Ј–≤–Є—З–∞–є–љ–Њ –≤–µ–ї–Є–Ї–Є–Љ–Є –Љ–Њ–і–µ–ї—П–Љ–Є –∞–±–Њ –љ–∞–±–Њ—А–∞–Љ–Є –і–∞–љ–Є—Е, –Њ–±–Є—А–∞—О—В—М —А—Ц—И–µ–љ–љ—П –љ–∞ –Њ—Б–љ–Њ–≤—Ц JAX, –њ–µ—А—И –Ј–∞ –≤—Б–µ, —З–µ—А–µ–Ј –њ–µ—А–µ–≤–∞–≥–Є –≤ –њ—А–Њ–і—Г–Ї—В–Є–≤–љ–Њ—Б—В—Ц. –Ь–Њ–і–µ–ї—Ц, –љ–∞–≤—З–∞–љ–љ—П —П–Ї–Є—Е –љ–∞ —Ц–љ—И–Є—Е —Д—А–µ–є–Љ–≤–Њ—А–Ї–∞—Е –Ј–∞–є–Љ–∞–ї–Њ –± —В–Є–ґ–љ—Ц, —З–∞—Б—В–Њ –Љ–Њ–ґ–љ–∞ –Ј–∞–≤–µ—А—И–Є—В–Є –Ј–∞ –і–Њ–њ–Њ–Љ–Њ–≥–Њ—О JAX –Ј–∞ –і–Њ–њ–Њ–Љ–Њ–≥–Њ—О –Ї—Ц–ї—М–Ї–Њ—Е –і–љ—Ц–≤, —Й–Њ –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф –Ј–љ–∞—З–љ—Г –µ–Ї–Њ–љ–Њ–Љ—Ц—О —А–µ—Б—Г—А—Б—Ц–≤ —Е–Љ–∞—А–љ–Є—Е –Њ–±—З–Є—Б–ї–µ–љ—М.

–§—Г–љ–Ї—Ж—Ц–Њ–љ–∞–ї—М–љ–Є–є –њ—Ц–і—Е—Ц–і —В–∞–Ї–Њ–ґ –њ—А–Є–љ–Њ—Б–Є—В—М –њ–µ—А–µ–≤–∞–≥–Є –і–ї—П –≤—Ц–і—В–≤–Њ—А—О–≤–∞–љ–Њ—Б—В—Ц —В–∞ –љ–∞–ї–∞–≥–Њ–і–ґ–µ–љ–љ—П, —П–Ї—Ц —Б—В–∞—О—В—М –і–µ–і–∞–ї—Ц –≤–∞–ґ–ї–Є–≤—Ц—И–Є–Љ–Є –Ј—Ц –Ј—А–Њ—Б—В–∞–љ–љ—П–Љ —Б–Ї–ї–∞–і–љ–Њ—Б—В—Ц –Љ–Њ–і–µ–ї–µ–є —В–∞ –Ј–±—Ц–ї—М—И–µ–љ–љ—П–Љ –≤–∞—А—В–Њ—Б—В—Ц –љ–∞–≤—З–∞–ї—М–љ–Є—Е —Ж–Є–Ї–ї—Ц–≤.

–Ж–і–µ–∞–ї—М–љ—Ц –≤–∞—А—Ц–∞–љ—В–Є –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П

JAX NLP —Ц–і–µ–∞–ї—М–љ–Њ –њ—Ц–і—Е–Њ–і–Є—В—М –і–ї—П:

–Э–∞–≤—З–∞–љ–љ—П —В–∞ —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П –і—Г–ґ–µ –≤–µ–ї–Є–Ї–Є—Е –Љ–Њ–≤–љ–Є—Е –Љ–Њ–і–µ–ї–µ–є

–Ю—А–≥–∞–љ—Ц–Ј–∞—Ж—Ц–є –Ј –і–Њ—Б—В—Г–њ–Њ–Љ –і–Њ —Б–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ–Њ–≥–Њ –Њ–±–ї–∞–і–љ–∞–љ–љ—П (TPU —В–Њ—Й–Њ)

–Я—А–Њ–µ–Ї—В—Ц–≤, —Й–Њ –≤–Є–Љ–∞–≥–∞—О—В—М –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–Њ—Ч –Њ–±—З–Є—Б–ї—О–≤–∞–ї—М–љ–Њ—Ч –µ—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В—Ц

–°–Є—В—Г–∞—Ж—Ц–є, –і–µ –≤—Ц–і—В–≤–Њ—А—О–≤–∞–љ—Ц—Б—В—М —Ф –Ї—А–Є—В–Є—З–љ–Њ –≤–∞–ґ–ї–Є–≤–Њ—О

–Ч–∞—Б—В–Њ—Б—Г–љ–Ї—Ц–≤, —Й–Њ –≤–Є–Љ–∞–≥–∞—О—В—М —Б—Г–≤–Њ—А–Є—Е –≥–∞—А–∞–љ—В—Ц–є –Ї–Њ–љ—Д—Ц–і–µ–љ—Ж—Ц–є–љ–Њ—Б—В—Ц

–Ь—Ц—А–Ї—Г–≤–∞–љ–љ—П

–Ь–Њ–і–µ–ї—М –њ—А–Њ–≥—А–∞–Љ—Г–≤–∞–љ–љ—П JAX, —Е–Њ—З–∞ –є –њ–Њ—В—Г–ґ–љ–∞, —П–≤–ї—П—Ф —Б–Њ–±–Њ—О –Ј–љ–∞—З–љ–Є–є –≤—Ц–і—Е—Ц–і –≤—Ц–і –±—Ц–ї—М—И –Ј–≤–Є—З–љ–Є—Е –Њ–±'—Ф–Ї—В–љ–Њ-–Њ—А—Ц—Ф–љ—В–Њ–≤–∞–љ–Є—Е –њ—Ц–і—Е–Њ–і—Ц–≤ —Ц–љ—И–Є—Е —Д—А–µ–є–Љ–≤–Њ—А–Ї—Ц–≤. –¶–µ –Љ–Њ–ґ–µ –Ј–±—Ц–ї—М—И–Є—В–Є –њ–Њ—З–∞—В–Ї–Њ–≤—Г –Ї—А–Є–≤—Г –љ–∞–≤—З–∞–љ–љ—П, –Њ—Б–Њ–±–ї–Є–≤–Њ –і–ї—П —А–Њ–Ј—А–Њ–±–љ–Є–Ї—Ц–≤ –±–µ–Ј —Б–Є–ї—М–љ–Њ–≥–Њ –і–Њ—Б–≤—Ц–і—Г —Д—Г–љ–Ї—Ж—Ц–Њ–љ–∞–ї—М–љ–Њ–≥–Њ –њ—А–Њ–≥—А–∞–Љ—Г–≤–∞–љ–љ—П. –Ъ—А—Ц–Љ —В–Њ–≥–Њ, —Е–Њ—З–∞ –µ–Ї–Њ—Б–Є—Б—В–µ–Љ–∞ —И–≤–Є–і–Ї–Њ –Ј—А–Њ—Б—В–∞—Ф, –≤–Њ–љ–∞ –≤—Б–µ —Й–µ –Љ–∞—Ф –Љ–µ–љ—И–µ –≥–Њ—В–Њ–≤–Є—Е –і–Њ –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П –Ї–Њ–Љ–њ–Њ–љ–µ–љ—В—Ц–≤, –љ—Ц–ґ –±—Ц–ї—М—И —Г—Б—В–∞–ї–µ–љ—Ц —Д—А–µ–є–Љ–≤–Њ—А–Ї–Є.

6. TensorFlow Text 3.0: –°—В–∞–±—Ц–ї—М–љ—Ц—Б—В—М –њ—Ц–і–њ—А–Є—Ф–Љ—Б—В–≤–∞

–Ъ–ї—О—З–Њ–≤—Ц —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–Є —В–∞ –њ–Њ–Ї—А–∞—Й–µ–љ–љ—П

TensorFlow Text 3.0 –њ—А–Њ–њ–Њ–љ—Г—Ф –Ї—Ц–ї—М–Ї–∞ –≤–∞–ґ–ї–Є–≤–Є—Е —Г–і–Њ—Б–Ї–Њ–љ–∞–ї–µ–љ—М:

–Ж–љ—В–µ–≥—А–∞—Ж—Ц—П –Ј TF Extended: –С–µ–Ј–њ–µ—А–µ–±—Ц–є–љ–µ –њ—Ц–і–Ї–ї—О—З–µ–љ–љ—П –і–Њ —Ц–љ—Б—В—А—Г–Љ–µ–љ—В—Ц–≤ –Ї–Њ–љ–≤–µ—Ф—А–∞ –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –љ–∞–≤—З–∞–љ–љ—П TensorFlow —Б–њ—А–Њ—Й—Г—Ф —И–ї—П—Е –≤—Ц–і –µ–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В—Ц–≤ –і–Њ —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П.

–Я–Њ–Ї—А–∞—Й–µ–љ–∞ –њ—Ц–і—В—А–Є–Љ–Ї–∞ TFLite: –Я–Њ–Ї—А–∞—Й–µ–љ—Ц –Њ–њ–µ—А–∞—Ж—Ц—Ч –Њ–±—А–Њ–±–Ї–Є —В–µ–Ї—Б—В—Г –≤ TFLite —А–Њ–±–ї—П—В—М —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П –Љ–Њ–і–µ–ї–µ–є NLP –љ–∞ –Љ–Њ–±—Ц–ї—М–љ–Є—Е —В–∞ –њ–µ—А–Є—Д–µ—А—Ц–є–љ–Є—Е –њ—А–Є—Б—В—А–Њ—П—Е –±—Ц–ї—М—И –њ—А–∞–Ї—В–Є—З–љ–Є–Љ.

–£–Ј–≥–Њ–і–ґ–µ–љ–Є–є –Ї—А–Њ—Б–њ–ї–∞—В—Д–Њ—А–Љ–љ–Є–є –і–Њ—Б–≤—Ц–і: –Ю–і–љ—Ц –є —В—Ц –ґ –Љ–Њ–і–µ–ї—Ц —В–∞ –Ї–Њ–љ–≤–µ—Ф—А–Є –Њ–±—А–Њ–±–Ї–Є –љ–∞–і—Ц–є–љ–Њ –њ—А–∞—Ж—О—О—В—М —Г —А—Ц–Ј–љ–Є—Е —Б–µ—А–µ–і–Њ–≤–Є—Й–∞—Е –љ–∞–≤—З–∞–љ–љ—П —В–∞ –ї–Њ–≥—Ц—З–љ–Њ–≥–Њ –≤–Є—Б–љ–Њ–≤–Ї—Г, –≤—Ц–і —Е–Љ–∞—А–љ–Є—Е TPU –і–Њ –Љ–Њ–±—Ц–ї—М–љ–Є—Е –њ—А–Є—Б—В—А–Њ—Ч–≤.

–†–Њ–Ј—И–Є—А–µ–љ–∞ –Ї–Њ—А–њ–Њ—А–∞—В–Є–≤–љ–∞ —Ц–љ—В–µ–≥—А–∞—Ж—Ц—П: –Т–±—Г–і–Њ–≤–∞–љ—Ц –Ї–Њ–љ–µ–Ї—В–Њ—А–Є –і–ї—П –њ–Њ—И–Є—А–µ–љ–Є—Е –і–ґ–µ—А–µ–ї –Ї–Њ—А–њ–Њ—А–∞—В–Є–≤–љ–Є—Е –і–∞–љ–Є—Е —Б–њ—А–Њ—Й—Г—О—В—М —Ц–љ—В–µ–≥—А–∞—Ж—Ц—О –Њ–±—А–Њ–±–Ї–Є —В–µ–Ї—Б—В—Г –≤ —Ц—Б–љ—Г—О—З—Ц —А–Њ–±–Њ—З—Ц –њ—А–Њ—Ж–µ—Б–Є.

–Ъ–Њ–Љ–њ–ї–µ–Ї—Б–љ—Ц –≤–∞—А—Ц–∞–љ—В–Є –Њ–±—Б–ї—Г–≥–Њ–≤—Г–≤–∞–љ–љ—П: –Т—Ц–і TF Serving –і–Њ SavedModel —В–∞ TFLite, –≤–∞—А—Ц–∞–љ—В–Є —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П –Њ—Е–Њ–њ–ї—О—О—В—М –њ—А–∞–Ї—В–Є—З–љ–Њ –±—Г–і—М-—П–Ї–µ —Ж—Ц–ї—М–Њ–≤–µ —Б–µ—А–µ–і–Њ–≤–Є—Й–µ.

–І–Њ–Љ—Г –Њ—А–≥–∞–љ—Ц–Ј–∞—Ж—Ц—Ч –Њ–±–Є—А–∞—О—В—М –є–Њ–≥–Њ

TensorFlow Text –Ј–∞–ї–Є—И–∞—Ф—В—М—Б—П –њ–Њ–њ—Г–ї—П—А–љ–Є–Љ —Г –Ї–Њ—А–њ–Њ—А–∞—В–Є–≤–љ–Є—Е —Б–µ—А–µ–і–Њ–≤–Є—Й–∞—Е, –Њ—Б–Ї—Ц–ї—М–Ї–Є –њ—А–Њ–њ–Њ–љ—Г—Ф –Ї–Њ–Љ–њ–ї–µ–Ї—Б–љ–µ —А—Ц—И–µ–љ–љ—П –≤—Ц–і –њ—Ц–і–≥–Њ—В–Њ–≤–Ї–Є –і–∞–љ–Є—Е –і–Њ —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П. –°—В–∞–±—Ц–ї—М–љ—Ц—Б—В—М API —В–∞ —И–Є—А–Њ–Ї—Ц –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П –Ј–љ–Є–ґ—Г—О—В—М —А–Є–Ј–Є–Ї, –њ–Њ–≤'—П–Ј–∞–љ–Є–є –Ј —Ц–љ—В–µ–≥—А–∞—Ж—Ц—Ф—О NLP —Г –Ї—А–Є—В–Є—З–љ–Њ –≤–∞–ґ–ї–Є–≤—Ц –њ—А–Њ–≥—А–∞–Љ–Є.

–Ж–љ—В–µ–≥—А–∞—Ж—Ц—П –Ј —Е–Љ–∞—А–љ–Є–Љ–Є –њ—А–Њ–њ–Њ–Ј–Є—Ж—Ц—П–Љ–Є Google —В–∞–Ї–Њ–ґ –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф –њ—А–Њ—Б—В–Є–є —И–ї—П—Е –Љ–∞—Б—И—В–∞–±—Г–≤–∞–љ–љ—П –і–ї—П –Њ—А–≥–∞–љ—Ц–Ј–∞—Ж—Ц–є, —П–Ї—Ц –≤–ґ–µ —Ц–љ–≤–µ—Б—В—Г–≤–∞–ї–Є –≤ —Ж—О –µ–Ї–Њ—Б–Є—Б—В–µ–Љ—Г.

–Ж–і–µ–∞–ї—М–љ—Ц –≤–∞—А—Ц–∞–љ—В–Є –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П

TensorFlow Text 3.0 —З—Г–і–Њ–≤–Њ –њ—Ц–і—Е–Њ–і–Є—В—М –і–ї—П:

–Ъ–Њ—А–њ–Њ—А–∞—В–Є–≤–љ–Є—Е –њ—А–Њ–≥—А–∞–Љ, —Й–Њ –≤–Є–Љ–∞–≥–∞—О—В—М —Б—В–∞–±—Ц–ї—М–љ–Њ—Б—В—Ц –≤–Є—А–Њ–±–љ–Є—Ж—В–≤–∞

–Ь–Њ–±—Ц–ї—М–љ–Є—Е —В–∞ –њ–µ—А–Є—Д–µ—А—Ц–є–љ–Є—Е —Б—Ж–µ–љ–∞—А—Ц—Ч–≤ —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П

–Ю—А–≥–∞–љ—Ц–Ј–∞—Ж—Ц–є –Ј —Ц—Б–љ—Г—О—З–Є–Љ–Є —Ц–љ–≤–µ—Б—В–Є—Ж—Ц—П–Љ–Є –≤ TensorFlow

–Я—А–Њ–µ–Ї—В—Ц–≤, —Й–Њ –њ–Њ—В—А–µ–±—Г—О—В—М –Ї–Њ–Љ–њ–ї–µ–Ї—Б–љ–Є—Е –Ї–Њ–љ–≤–µ—Ф—А—Ц–≤ –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –љ–∞–≤—З–∞–љ–љ—П

–Я—А–Њ–≥—А–∞–Љ, –і–µ –≥–љ—Г—З–Ї—Ц—Б—В—М —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П —Ф –≤–∞–ґ–ї–Є–≤–Њ—О

–Ь—Ц—А–Ї—Г–≤–∞–љ–љ—П

–•–Њ—З–∞ TensorFlow Text –њ—А–Њ–і–Њ–≤–ґ—Г—Ф –і–Њ–і–∞–≤–∞—В–Є –љ–Њ–≤—Ц –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц, –≤—Ц–љ —Ц–љ–Њ–і—Ц –≤—Ц–і—Б—В–∞—Ф –≤—Ц–і —Ц–љ—И–Є—Е —Д—А–µ–є–Љ–≤–Њ—А–Ї—Ц–≤ —Г –≤–њ—А–Њ–≤–∞–і–ґ–µ–љ–љ—Ц –Њ—Б—В–∞–љ–љ—Ц—Е –і–Њ—Б—П–≥–љ–µ–љ—М –і–Њ—Б–ї—Ц–і–ґ–µ–љ—М. –Ъ—А—Ц–Љ —В–Њ–≥–Њ, –і–µ—П–Ї—Ц —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –≤–≤–∞–ґ–∞—О—В—М –Љ–Њ–і–µ–ї—М —Б–Є–Љ–≤–Њ–ї—Ц—З–љ–Њ–≥–Њ –њ—А–Њ–≥—А–∞–Љ—Г–≤–∞–љ–љ—П –Љ–µ–љ—И —Ц–љ—В—Г—Ч—В–Є–≤–љ–Њ—О –і–ї—П –µ–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В—Ц–≤ –њ–Њ—А—Ц–≤–љ—П–љ–Њ –Ј —Ц–Љ–њ–µ—А–∞—В–Є–≤–љ–Є–Љ –њ—Ц–і—Е–Њ–і–Њ–Љ PyTorch.

7. Flair 2.0: –®–≤–µ–є—Ж–∞—А—Б—М–Ї–Є–є –∞—А–Љ—Ц–є—Б—М–Ї–Є–є –љ—Ц–ґ –Э–Ы–Я

–Ъ–ї—О—З–Њ–≤—Ц —Е–∞—А–∞–Ї—В–µ—А–Є—Б—В–Є–Ї–Є —В–∞ –њ–Њ–Ї—А–∞—Й–µ–љ–љ—П

Flair 2.0 –њ—А–Њ–њ–Њ–љ—Г—Ф –Ї—Ц–ї—М–Ї–∞ –њ–Њ–Љ—Ц—В–љ–Є—Е –њ–Њ–Ї—А–∞—Й–µ–љ—М:

–У—Ц–±—А–Є–і–љ–∞ —Б—В—А—Г–Ї—В—Г—А–∞ –≤–±—Г–і–Њ–≤—Г–≤–∞–љ–љ—П: –Ы–µ–≥–Ї–Њ –њ–Њ—Ф–і–љ—Г–є—В–µ —А—Ц–Ј–љ—Ц —В–Є–њ–Є –≤–±—Г–і–Њ–≤—Г–≤–∞–љ–љ—П (–Ї–Њ–љ—В–µ–Ї—Б—В–љ—Ц, —Б—В–∞—В–Є—З–љ—Ц, –љ–∞ —А—Ц–≤–љ—Ц —Б–Є–Љ–≤–Њ–ї—Ц–≤) –і–ї—П –і–Њ—Б—П–≥–љ–µ–љ–љ—П –Њ–њ—В–Є–Љ–∞–ї—М–љ–Њ—Ч –њ—А–Њ–і—Г–Ї—В–Є–≤–љ–Њ—Б—В—Ц –і–ї—П –Ї–Њ–љ–Ї—А–µ—В–љ–Є—Е –Ј–∞–≤–і–∞–љ—М.

–Ь–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц –Њ–і–љ–Њ—А–∞–Ј–Њ–≤–Њ–≥–Њ –љ–∞–≤—З–∞–љ–љ—П: –Э–Њ–≤—Ц –Љ–µ—В–Њ–і–Є –Њ–і–љ–Њ—А–∞–Ј–Њ–≤–Њ–≥–Њ –љ–∞–≤—З–∞–љ–љ—П –Ј–∞–±–µ–Ј–њ–µ—З—Г—О—В—М –љ–∞–њ—А–Њ—З—Г–і —Е–Њ—А–Њ—И—Ц —А–µ–Ј—Г–ї—М—В–∞—В–Є –і–ї—П —Б–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ–Є—Е –Ј–∞–≤–і–∞–љ—М –Ј –Љ—Ц–љ—Ц–Љ–∞–ї—М–љ–Њ—О –Ї—Ц–ї—М–Ї—Ц—Б—В—О –Љ–∞—А–Ї–Њ–≤–∞–љ–Є—Е –і–∞–љ–Є—Е.

–Я–Њ–Ї—А–∞—Й–µ–љ–Є–є —Ц–љ—В–µ–ї–µ–Ї—В –і–Њ–Ї—Г–Љ–µ–љ—В—Ц–≤: –Я–Њ–Ї—А–∞—Й–µ–љ—Ц –њ—Ц–і—Е–Њ–і–Є –і–Њ –Љ–Њ–і–µ–ї—О–≤–∞–љ–љ—П –і–Њ–Ї—Г–Љ–µ–љ—В—Ц–≤ –Ї—А–∞—Й–µ —Д—Ц–Ї—Б—Г—О—В—М –і–Њ–≤–≥–Њ—Б—В—А–Њ–Ї–Њ–≤—Ц –Ј–∞–ї–µ–ґ–љ–Њ—Б—В—Ц –≤ –і–Њ–≤–≥–Є—Е —В–µ–Ї—Б—В–∞—Е.

–Ю–њ—В–Є–Љ—Ц–Ј–Њ–≤–∞–љ–µ —В–Њ—З–љ–µ –љ–∞–ї–∞—И—В—Г–≤–∞–љ–љ—П: –°–њ—А–Њ—Й–µ–љ—Ц —А–Њ–±–Њ—З—Ц –њ—А–Њ—Ж–µ—Б–Є –і–ї—П –∞–і–∞–њ—В–∞—Ж—Ц—Ч –њ–Њ–њ–µ—А–µ–і–љ—М–Њ –љ–∞–≤—З–µ–љ–Є—Е –Љ–Њ–і–µ–ї–µ–є –і–Њ –њ–µ–≤–љ–Є—Е –і–Њ–Љ–µ–љ—Ц–≤ –∞–±–Њ –Ј–∞–≤–і–∞–љ—М.

–Ь–µ–љ—И—Ц –≤–Є–Љ–Њ–≥–Є –і–Њ —А–µ—Б—Г—А—Б—Ц–≤: –Я—Ц–і–≤–Є—Й–µ–љ–∞ –µ—Д–µ–Ї—В–Є–≤–љ—Ц—Б—В—М —А–Њ–±–Є—В—М Flair –њ—А–Є–і–∞—В–љ–Є–Љ –і–ї—П —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П –љ–∞ –Љ–µ–љ—И –њ–Њ—В—Г–ґ–љ–Њ–Љ—Г –Њ–±–ї–∞–і–љ–∞–љ–љ—Ц.

–І–Њ–Љ—Г —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –Њ–±–Є—А–∞—О—В—М –є–Њ–≥–Њ

Flair –Ј–і–Њ–±—Г–≤ –≤—Ц–і–і–∞–љ—Г –њ–Њ–њ—Г–ї—П—А–љ—Ц—Б—В—М, –Њ—Б–Ї—Ц–ї—М–Ї–Є –≤—Ц–љ –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф —З—Г–і–Њ–≤–Є–є –±–∞–ї–∞–љ—Б –Љ—Ц–ґ –њ–Њ—В—Г–ґ–љ—Ц—Б—В—О —В–∞ –њ—А–Њ—Б—В–Њ—В–Њ—О. –С—Ц–±–ї—Ц–Њ—В–µ–Ї–∞ –њ—А–Њ–њ–Њ–љ—Г—Ф –Љ–∞–є–ґ–µ –љ–∞–є—Б—Г—З–∞—Б–љ—Ц—И—Г –њ—А–Њ–і—Г–Ї—В–Є–≤–љ—Ц—Б—В—М –і–ї—П –±–∞–≥–∞—В—М–Њ—Е –њ–Њ—И–Є—А–µ–љ–Є—Е –Ј–∞–≤–і–∞–љ—М NLP, –≤–Є–Љ–∞–≥–∞—О—З–Є –њ—А–Є —Ж—М–Њ–Љ—Г –Ј–љ–∞—З–љ–Њ –Љ–µ–љ—И–µ –Ї–Њ–і—Г —В–∞ –Њ–±—З–Є—Б–ї—О–≤–∞–ї—М–љ–Є—Е —А–µ—Б—Г—А—Б—Ц–≤, –љ—Ц–ґ —Б–Ї–ї–∞–і–љ—Ц—И—Ц —Д—А–µ–є–Љ–≤–Њ—А–Ї–Є.

–Ж–љ—В—Г—Ч—В–Є–≤–љ–Њ –Ј—А–Њ–Ј—Г–Љ—Ц–ї–Є–є –і–Є–Ј–∞–є–љ API —В–∞–Ї–Њ–ґ —А–Њ–±–Є—В—М –є–Њ–≥–Њ –і–Њ—Б—В—Г–њ–љ–Є–Љ –і–ї—П —А–Њ–Ј—А–Њ–±–љ–Є–Ї—Ц–≤, —П–Ї—Ц –љ–µ —Ф —Д–∞—Е—Ц–≤—Ж—П–Љ–Є –Ј NLP, –і–Њ–Ј–≤–Њ–ї—П—О—З–Є —Ч–Љ —Ц–љ—В–µ–≥—А—Г–≤–∞—В–Є —Б–Ї–ї–∞–і–љ–µ —А–Њ–Ј—Г–Љ—Ц–љ–љ—П –Љ–Њ–≤–Є —Г —Б–≤–Њ—Ч –њ—А–Њ–≥—А–∞–Љ–Є –Ј –≤—Ц–і–љ–Њ—Б–љ–Њ –ї–µ–≥–Ї–Њ—О –Ї—А–Є–≤–Њ—О –љ–∞–≤—З–∞–љ–љ—П.

–Ж–і–µ–∞–ї—М–љ—Ц –≤–∞—А—Ц–∞–љ—В–Є –≤–Є–Ї–Њ—А–Є—Б—В–∞–љ–љ—П

Flair 2.0 –љ–∞–є–Ї—А–∞—Й–µ –њ—Ц–і—Е–Њ–і–Є—В—М –і–ї—П:

–Я—А–Њ–µ–Ї—В—Ц–≤, —Й–Њ –≤–Є–Љ–∞–≥–∞—О—В—М –≤—Ц–і–Љ—Ц–љ–љ–Њ–≥–Њ –Љ–∞—А–Ї—Г–≤–∞–љ–љ—П –њ–Њ—Б–ї—Ц–і–Њ–≤–љ–Њ—Б—В–µ–є (NER, POS-—В–µ–≥—Г–≤–∞–љ–љ—П)

–Я—А–Њ–≥—А–∞–Љ –Ј –Њ–±–Љ–µ–ґ–µ–љ–Є–Љ–Є –Њ–±—З–Є—Б–ї—О–≤–∞–ї—М–љ–Є–Љ–Є —А–µ—Б—Г—А—Б–∞–Љ–Є

–Ъ–Њ–Љ–∞–љ–і, —П–Ї—Ц —И—Г–Ї–∞—О—В—М —И–≤–Є–і–Ї—Г —А–µ–∞–ї—Ц–Ј–∞—Ж—Ц—О —Б—В–∞–љ–і–∞—А—В–љ–Є—Е –Ј–∞–≤–і–∞–љ—М NLP

–°—Ж–µ–љ–∞—А—Ц–є –Ј –Љ—Ц–љ—Ц–Љ–∞–ї—М–љ–Є–Љ–Є –Љ–∞—А–Ї–Њ–≤–∞–љ–Є–Љ–Є –љ–∞–≤—З–∞–ї—М–љ–Є–Љ–Є –і–∞–љ–Є–Љ–Є

–°–њ–µ—Ж—Ц–∞–ї—Ц–Ј–Њ–≤–∞–љ–Є—Е –њ—А–Њ–≥—А–∞–Љ –Ї–ї–∞—Б–Є—Д—Ц–Ї–∞—Ж—Ц—Ч —В–µ–Ї—Б—В—Г

–Ь—Ц—А–Ї—Г–≤–∞–љ–љ—П

–•–Њ—З–∞ Flair –њ—А–Њ–і–Њ–≤–ґ—Г—Ф —А–Њ–Ј—И–Є—А—О–≤–∞—В–Є —Б–≤–Њ—Ч –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц, –≤—Ц–љ –љ–µ –њ—А–Њ–њ–Њ–љ—Г—Ф —В–∞–Ї–Њ–≥–Њ –ґ —И–Є—А–Њ–Ї–Њ–≥–Њ —Б–њ–µ–Ї—В—А—Г –Љ–Њ–і–µ–ї–µ–є —В–∞ –Љ–µ—В–Њ–і—Ц–≤, —П–Ї –±—Ц–ї—М—И—Ц —Д—А–µ–є–Љ–≤–Њ—А–Ї–Є, —В–∞–Ї—Ц —П–Ї Hugging Face Transformers. –Ъ—А—Ц–Љ —В–Њ–≥–Њ, –і–µ—П–Ї—Ц —А–Њ–Ј—А–Њ–±–љ–Є–Ї–Є –Ј–∞–Ј–љ–∞—З–∞—О—В—М, —Й–Њ –є–Њ–≥–Њ –і–Њ–Ї—Г–Љ–µ–љ—В–∞—Ж—Ц—П, —Е–Њ—З–∞ –є –њ–Њ–Ї—А–∞—Й—Г—Ф—В—М—Б—П, –≤—Б–µ —Й–µ –љ–µ –Љ—Ц—Б—В–Є—В—М –≤–Є—З–µ—А–њ–љ–Є—Е –њ—А–Є–Ї–ї–∞–і—Ц–≤, —П–Ї—Ц –Љ–Њ–ґ–љ–∞ –Ј–љ–∞–є—В–Є –≤ –±—Ц–ї—М—И —Г—Б—В–∞–ї–µ–љ–Є—Е –±—Ц–±–ї—Ц–Њ—В–µ–Ї–∞—Е.

–Т–Є—Б–љ–Њ–≤–Њ–Ї: –Т–Є–±—Ц—А –њ—А–∞–≤–Є–ї—М–љ–Њ—Ч –±—Ц–±–ї—Ц–Њ—В–µ–Ї–Є –Э–Ы–Я –і–ї—П –≤–∞—И–Є—Е –њ–Њ—В—А–µ–±

Hugging Face Transformers 6.0 –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф –љ–∞–є–њ–Њ–≤–љ—Ц—И–Є–є –≤–Є–±—Ц—А –µ–Ї–Њ—Б–Є—Б—В–µ–Љ–Є —В–∞ –Љ–Њ–і–µ–ї–µ–є

SpaCy 4.0 –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф –њ—А–Њ–Љ–Є—Б–ї–Њ–≤—Г –њ—А–Њ–і—Г–Ї—В–Є–≤–љ—Ц—Б—В—М —В–∞ –љ–∞–і—Ц–є–љ—Ц—Б—В—М –≤–Є—А–Њ–±–љ–Є—Ж—В–≤–∞

Cohere SDK –њ—А–Њ–њ–Њ–љ—Г—Ф –Ј—А—Г—З–љ—Ц—Б—В—М API-first –Ј –њ–Њ—Б—В—Ц–є–љ–Њ –Њ–љ–Њ–≤–ї—О–≤–∞–љ–Є–Љ–Є –Љ–Њ–і–µ–ї—П–Љ–Є

PyTorch NLP –љ–∞–і–∞—Ф –і–Њ—Б–ї—Ц–і–љ–Є–Ї–∞–Љ –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Г –≥–љ—Г—З–Ї—Ц—Б—В—М —В–∞ –Ї–Њ–љ—В—А–Њ–ї—М

JAX NLP –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф –љ–µ–њ–µ—А–µ–≤–µ—А—И–µ–љ—Г –њ—А–Њ–і—Г–Ї—В–Є–≤–љ—Ц—Б—В—М –і–ї—П –≤–µ–ї–Є–Ї–Њ–Љ–∞—Б—И—В–∞–±–љ–Є—Е –њ—А–Њ–≥—А–∞–Љ

TensorFlow Text 3.0 –Ј–∞–±–µ–Ј–њ–µ—З—Г—Ф —Б—В–∞–±—Ц–ї—М–љ—Ц—Б—В—М —В–∞ –≤–∞—А—Ц–∞–љ—В–Є —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П –і–ї—П –њ—Ц–і–њ—А–Є—Ф–Љ—Б—В–≤

Flair 2.0 –њ–Њ—Ф–і–љ—Г—Ф –≤—А–∞–ґ–∞—О—З—Ц –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц –≤ –ї–µ–≥–Ї–Њ–Љ—Г –Ї–Њ—А–њ—Г—Б—Ц

–Я—А–∞–≤–Є–ї—М–љ–Є–є –≤–Є–±—Ц—А –Ј–∞–ї–µ–ґ–Є—В—М –≤—Ц–і –≤–∞—И–Є—Е –Ї–Њ–љ–Ї—А–µ—В–љ–Є—Е –≤–Є–Љ–Њ–≥:

–Ф–ї—П —И–≤–Є–і–Ї–Њ–≥–Њ –њ—А–Њ—В–Њ—В–Є–њ—Г–≤–∞–љ–љ—П —В–∞ –і–Њ—Б—В—Г–њ—Г –і–Њ –љ–∞–є—Б—Г—З–∞—Б–љ—Ц—И–Є—Е –Љ–Њ–і–µ–ї–µ–є Hugging Face Transformers –Ј–∞–ї–Є—И–∞—Ф—В—М—Б—П –≤–∞–ґ–Ї–Њ –њ–µ—А–µ–≤–µ—А—И–Є—В–Є. –ѓ–Ї—Й–Њ –љ–∞–і—Ц–є–љ—Ц—Б—В—М —В–∞ –µ—Д–µ–Ї—В–Є–≤–љ—Ц—Б—В—М –≤–Є—А–Њ–±–љ–Є—Ж—В–≤–∞ —Ф –≤–∞—И–Є–Љ–Є –≥–Њ–ї–Њ–≤–љ–Є–Љ–Є –њ—А–Њ–±–ї–µ–Љ–∞–Љ–Є, SpaCy –њ—А–Њ–і–Њ–≤–ґ—Г—Ф –њ–µ—А–µ–≤–µ—А—И—Г–≤–∞—В–Є. –Ъ–Њ–ї–Є —И–≤–Є–і–Ї—Ц—Б—В—М —А–Њ–Ј—А–Њ–±–Ї–Є —В–∞ –њ—А–Њ—Б—В–Њ—В–∞ –≤–њ—А–Њ–≤–∞–і–ґ–µ–љ–љ—П –Љ–∞—О—В—М –љ–∞–є–±—Ц–ї—М—И–µ –Ј–љ–∞—З–µ–љ–љ—П, –њ—Ц–і—Е—Ц–і Cohere, —Й–Њ –±–∞–Ј—Г—Ф—В—М—Б—П –љ–∞ API, –њ—А–Њ–њ–Њ–љ—Г—Ф –њ–µ—А–µ–Ї–Њ–љ–ї–Є–≤—Ц –њ–µ—А–µ–≤–∞–≥–Є.

–Ф–Њ—Б–ї—Ц–і–љ–Є–Ї–Є, —П–Ї–Є–Љ –њ–Њ—В—А—Ц–±–љ–∞ –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ–∞ –≥–љ—Г—З–Ї—Ц—Б—В—М, –≤—Б–µ —Й–µ —В—П–ґ—Ц—В–Є–Љ—Г—В—М –і–Њ PyTorch NLP, —В–Њ–і—Ц —П–Ї –Њ—А–≥–∞–љ—Ц–Ј–∞—Ж—Ц—Ч, —Й–Њ –љ–∞–≤—З–∞—О—В—М –Љ–∞—Б–Є–≤–љ—Ц –Љ–Њ–і–µ–ї—Ц, –Њ—В—А–Є–Љ–∞—О—В—М –≤–Є–≥–Њ–і—Г –≤—Ц–і –Њ–њ—В–Є–Љ—Ц–Ј–∞—Ж—Ц—Ч –њ—А–Њ–і—Г–Ї—В–Є–≤–љ–Њ—Б—В—Ц JAX. –Я—Ц–і–њ—А–Є—Ф–Љ—Б—В–≤–∞, —П–Ї—Ц —Ж—Ц–љ—Г—О—В—М —Б—В–∞–±—Ц–ї—М–љ—Ц—Б—В—М —В–∞ –Ї–Њ–Љ–њ–ї–µ–Ї—Б–љ—Ц –≤–∞—А—Ц–∞–љ—В–Є —А–Њ–Ј–≥–Њ—А—В–∞–љ–љ—П, –≤–≤–∞–ґ–∞—О—В—М TensorFlow Text –±–µ–Ј–њ–µ—З–љ–Є–Љ –≤–Є–±–Њ—А–Њ–Љ, –∞ –Ї–Њ–Љ–∞–љ–і–∞–Љ, —П–Ї—Ц —И—Г–Ї–∞—О—В—М –ї–µ–≥–Ї–µ —А—Ц—И–µ–љ–љ—П –Ј –≤—А–∞–ґ–∞—О—З–Є–Љ–Є –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—П–Љ–Є, –≤–∞—А—В–Њ —А–Њ–Ј–≥–ї—П–љ—Г—В–Є Flair. –Ю—Б–Ї—Ц–ї—М–Ї–Є —В–µ—Е–љ–Њ–ї–Њ–≥—Ц—П NLP –њ—А–Њ–і–Њ–≤–ґ—Г—Ф —А–Њ–Ј–≤–Є–≤–∞—В–Є—Б—П –љ–∞–і–Ј–≤–Є—З–∞–є–љ–Є–Љ–Є —В–µ–Љ–њ–∞–Љ–Є, –њ–Њ—Ц–љ—Д–Њ—А–Љ–Њ–≤–∞–љ—Ц—Б—В—М –њ—А–Њ –Љ–Њ–ґ–ї–Є–≤–Њ—Б—В—Ц —В–∞ —В–µ–љ–і–µ–љ—Ж—Ц—Ч —А–Њ–Ј–≤–Є—В–Ї—Г —Ж–Є—Е –±—Ц–±–ї—Ц–Њ—В–µ–Ї –і–Њ–њ–Њ–Љ–Њ–ґ–µ –≤–∞–Љ –Ј—А–Њ–±–Є—В–Є –љ–∞–є–Ї—А–∞—Й–Є–є –≤–Є–±—Ц—А –і–ї—П –≤–∞—И–Є—Е –њ—А–Њ–µ–Ї—В—Ц–≤ —В–∞ –њ—Ц–і—В—А–Є–Љ—Г–≤–∞—В–Є –≤–∞—И—Ц –њ—А–Њ–≥—А–∞–Љ–Є –љ–∞ –њ–µ—А–µ–і–Њ–≤—Ц–є. –ѓ–Ї–Є–є –≤–∞—И –љ–∞—Б—В—Г–њ–љ–Є–є NLP-–њ—А–Њ–µ–Ї—В, —Ц —П–Ї–∞ –Ј —Ж–Є—Е –±—Ц–±–ї—Ц–Њ—В–µ–Ї –Љ–Њ–ґ–µ —Ц–і–µ–∞–ї—М–љ–Њ –њ—Ц–і—Ц–є—В–Є –і–ї—П –≤–∞—И–Є—Е –Ї–Њ–љ–Ї—А–µ—В–љ–Є—Е –≤–Є–Љ–Њ–≥?